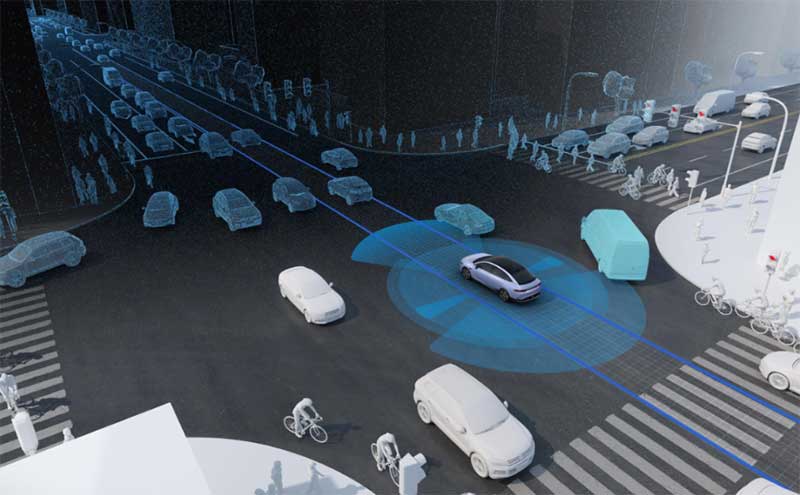

在自动驾驶技术方案中,“强化学习(Reinforcement Learning, RL)” 是高频提及的决策优化技术。它的核心逻辑是让车辆通过 “试错探索” 自主学会最优驾驶策略 —— 没有预设的 “正确答案”,全靠与环境交互中的奖励和惩罚积累经验,最终实现安全、高效的决策。下面用通俗的语言拆解其本质、应用场景、关键技术与落地挑战。

一、先搞懂:强化学习到底是什么?

强化学习的核心是 “智能体与环境的交互闭环”,可以类比为 “教汽车学开车” 的过程,关键概念用生活场景就能理解:

- 智能体:自动驾驶汽车本身(需要做决策的主体);

- 环境:道路、行人、其他车辆、交通信号灯等所有外部场景;

- 状态:车辆通过传感器感知到的实时信息(如 “前方 50 米有行人”“当前车速 60km/h”);

- 动作:车辆能执行的操作(转向、加速、刹车、保持车道等);

- 奖励 / 惩罚:环境对动作的反馈(安全通过路口 + 10 分、轻微顿挫 - 2 分、发生碰撞 - 100 分);

- 策略:车辆选择动作的规则(如 “看到行人减速”“高速跟车保持 2 秒车距”);

- 价值:对某个状态的长期收益评估(如 “保持当前车道” 比 “强行变道” 未来获得更多奖励)。

与监督学习(有明确标注的 “正确答案”)不同,强化学习没有 “标准答案”,全靠车辆自主探索 —— 就像新手司机练车,通过一次次尝试知道 “什么操作靠谱”,最终形成稳定的驾驶习惯。

二、强化学习在自动驾驶中的核心应用场景

强化学习擅长处理 “长期权衡” 和 “复杂交互” 类任务,在自动驾驶中主要落地于 3 个核心环节:

- 低层控制优化:针对转向、加速、刹车等基础操作,学习适配车辆动力学的控制策略。比如在冰雪路面、非铺装路面等复杂摩擦条件下,通过强化学习让控制更平稳,避免打滑或顿挫;

- 行为决策制定:解决需要长期权衡的场景,比如 “黄灯时是否通过路口”“高速上何时变道更高效”“跟车间距如何平衡安全与效率”。这类场景没有固定规则,强化学习能通过累积奖励找到最优解;

- 局部轨迹优化:在动态障碍场景中(如施工区临时改道、行人突然横穿),快速调整短周期轨迹,而非依赖固定的最优控制算法,适配性更强。

需要注意的是,目前强化学习很少直接替代整个自动驾驶系统,更多是作为 “辅助工具”—— 比如优化端到端模型的决策逻辑,或为传统规则引擎补充场景适配能力。

三、实现强化学习的关键技术:从设计到落地

要让强化学习在自动驾驶中可用,需解决 “状态定义、奖励设计、样本效率、安全保障” 四大核心问题:

1. 状态与奖励设计:避免 “走捷径”

- 状态设计:既要包含足够信息(如障碍物位置、车速、车道线状态),又不能过于冗余(否则学习效率低),通常会融合传感器数据与高精地图语义;

- 奖励设计:最关键也最复杂,需组合多项指标避免 “奖励劫持”(看似得分高但实际危险)。比如奖励体系会包含:安全项(无碰撞 + 30 分、侵占对向车道 - 50 分)、舒适项(平稳加速 + 5 分、急刹 - 15 分)、效率项(按时到达 + 20 分、偏离路线 - 10 分),同时用硬性约束确保安全底线。

2. 样本效率提升:解决 “真实路测不安全”

强化学习需要海量交互数据,但真实道路试错风险极高,因此核心依赖两大技术:

- 高保真仿真训练:在虚拟环境中生成海量场景(包括极端天气、长尾事件),让模型安全试错。通过 “领域随机化”(随机调整路面摩擦、光照、障碍物位置)缩小仿真与现实的差距;

- 离线强化学习:利用已记录的人类驾驶轨迹数据训练,无需实时探索。但需解决 “分布偏差” 问题 —— 避免模型学到的数据与真实场景脱节。

3. 算法选择:适配驾驶场景特性

-

连续动作场景(如转向角、刹车力度调节):优先用策略梯度类算法(如 PPO)或 Actor-Critic 架构,兼顾稳定性与样本效率; -

长期规划 + 短期控制结合场景:采用层次化强化学习,高层决策(是否变道)与低层控制(具体转向)分开学习,既降低复杂度,又提升可解释性。

4. 安全与稳定性保障:给 AI 加 “安全锁”

-

训练阶段:引入安全过滤器、约束层,禁止模型学习危险动作(如闯红灯、近距离加塞); -

部署阶段:采用 “安全外壳” 设计 —— 强化学习输出的动作,需先通过传统验证过的控制器检查,确认符合物理规则和安全边界后再执行;若出现异常,立即回退到保守策略(如减速、靠边停车)。

四、落地限制与工程建议:不盲目追求 “纯 RL”

尽管强化学习优势明显,但在自动驾驶高安全要求下,仍有三大核心限制:

- 可解释性弱:黑箱决策难以通过监管审查,无法追溯 “为什么做出某个动作”;

- 奖励设计风险:即使设计再精细,也可能出现未预料到的 “漏洞”(如模型为了不减速而绕过行人);

- 真实场景泛化难:仿真与现实的 “域差” 可能导致模型在真实道路表现退化。

因此,工程落地更推荐 “混合方案” 而非 “纯 RL”:

-

用模仿学习初始化策略(先学人类驾驶习惯,降低训练难度); -

用强化学习在仿真中优化策略(提升复杂场景适配性); -

用传统规则与约束保证安全(通过可解释的逻辑兜底); -

部署时采用 “分层验证”:先封闭场地测试,再逐步放宽真实道路场景,同时保留可回退机制。

五、总结:强化学习是 “优化工具” 而非 “替代方案”

强化学习的核心价值,是解决自动驾驶中 “无固定规则、需长期权衡” 的决策难题 —— 它能让车辆在复杂交互中自主找到最优解,而非局限于工程师预设的规则。但它并非 “万能钥匙”,无法单独支撑自动驾驶落地。

未来,强化学习的落地路径必然是 “互补融合”:与模仿学习、传统控制算法、规则引擎结合,在仿真中探索能力边界,在真实道路中稳健验证,在安全约束下释放优势。对行业而言,它不是要替代现有技术,而是成为自动驾驶从 “能开” 到 “开好、开稳” 的关键优化工具。

要不要我帮你整理一份强化学习在自动驾驶中的落地技术清单?涵盖仿真训练、奖励设计、安全部署的核心步骤与工具选型,方便你快速参考。

转载请注明:可思数据 » 自动驾驶中的强化学习:让汽车像 “学开车” 一样自主决策

免责声明:本站来源的信息均由网友自主投稿和发布、编辑整理上传,或转载于第三方平台,对此类作品本站仅提供交流平台,不为其版权负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本站联系,我们将及时更正、删除,谢谢。联系邮箱:elon368@sina.com