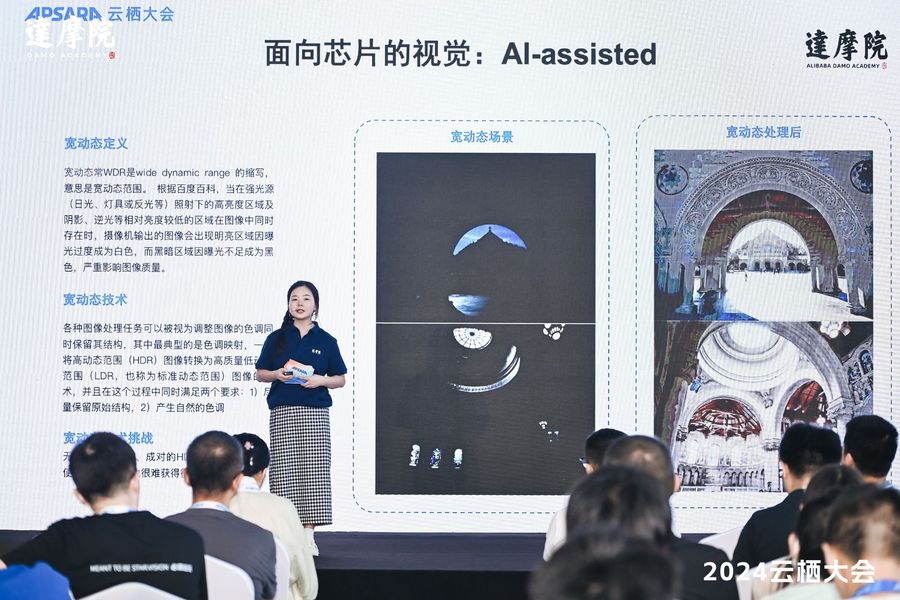

9月21日,阿里巴巴达摩院计算技术实验室在2024云栖大会上提出了一种基于结构保持网络的AI视觉算法,可将高动态范围(HDR)场景图像自动转换为低动态范围(LDR)图像并保持其纹理细节,在常规显示设备上的图像质量相比业界提升7%。

HDR图像同时包含强光源照射下的极亮区域和阴影、逆光下的极暗区域,容易出现明亮区域过曝、或者黑暗区域纯黑的情况,必须经过宽动态技术处理才能适配常规显示设备。传统的宽动态技术由于缺失自适应的局部与全局处理方法,会损失大量信息,生成结果局部粗糙或者全局锐化。业界也在探索基于AI的宽动态技术,最大挑战在于缺乏成对匹配的HDR-LDR数据,难以构建完备训练数据。

为此,该团队创新性地提出利用双流控制扩散网络保持图像在前向传播过程中的结构细节和色调风格,可实现零样本学习。具体而言,该方法采用平均值减除和对比度归一化(MSCN)技术,提取出HDR和LDR图像的共享结构特征作为 “桥梁”,引导扩散模型学习到HDR图像结构并维持LDR图像的色调风格,最终生成纹理细节丰富且色彩均衡的LDR图像。

基于标准的HDRPS色调映射数据集,该模型的NIQE和TMQI指标相比业界提升7.11%和0.61%。此外,达摩院团队将模型迁移到红外图像恢复领域,在公开的VIS-NIR数据集上取得了超过业界10%的效果。相关学术论文《Zero-Shot Structure-Preserving Diffusion Model for High Dynamic Range Tone Mapping》被国际计算机视觉与模式识别会议(CVPR)收录为今年亮点(Highlight)。

据达摩院计算技术实验室介绍,该技术可帮助ISP芯片实现更智能的光线适应性和动态范围调整,也有望与其他多种扩散模型结合,发展AIGC技术的新可能。面向图计算、自动驾驶、多模态AI、具身智能等新型计算需求,该团队将持续探索软硬件全栈创新,助力芯片产业和数字经济发展。

转载请注明:可思数据 » 阿里提出结构保持的AI视觉算法:显著提升HDR图像转LDR图像质量

免责声明:本站来源的信息均由网友自主投稿和发布、编辑整理上传,或转载于第三方平台,对此类作品本站仅提供交流平台,不为其版权负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本站联系,我们将及时更正、删除,谢谢。联系邮箱:elon368@sina.com