DeepSeek系列模型通过持续技术突破,在开源大模型领域树立了性能与成本效益的双重标杆。尤其在金融等垂直领域,其专业场景适配能力正重塑行业智能化转型的价值标准,为产业升级提供高性价比解决方案。

-

性能对齐海外领军闭源模型,垂直领域应用价值凸显。通过持续技术创新,DeepSeek实现了开源大模型性能与国际顶尖闭源模型的全面对标。其显著的成本优势使其成为当前最具性价比的AI大模型之一,尤其适合金融等垂直领域。

-

DeepSeek-V3:架构创新驱动效能跃升。优化的模型架构设计、多Token预测目标与FP8混合精度训练等技术亮点使模型在保持参数数量级优势的同时达成单位算力效能的最大化释放。

-

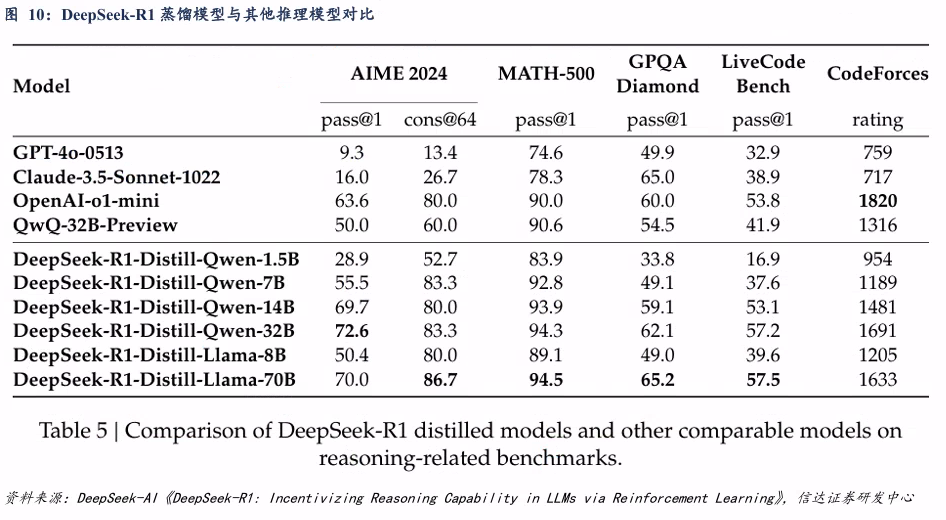

DeepSeek-R1:推理能力突破认知边界。优化的模型架构设计、多Token预测目标与FP8混合精度训练等技术亮点使模型在保持参数数量级优势的同时达成单位算力效能的最大化释放。DeepSeekR1-Zero展示了诸如自我验证、反思和生成长思维链的能力,标志着研究界的重要里程碑。为解决可读性差和语言混乱等问题,并进一步提高推理性能,结合多阶段强化学习以及监督微调,最终训练出强大的DeepSeek-R1。

DeepSeek网页版已构建起覆盖知识管理全流程的智能服务体系,用户通过自然语言交互即可实现多模态智能问答、跨格式文档解析、学术资源智能检索、可视化思维建构、自动化办公输出,其创新交互范式正在重塑企业级知识生产力工具的应用形态。

-

DeepSeek官网实现智能问答与文档解析功能。依托其强大的自然语言处理能力,用户仅通过DeepSeek官方对话网页即可实现智能问答、跨格式文档解析等功能。

-

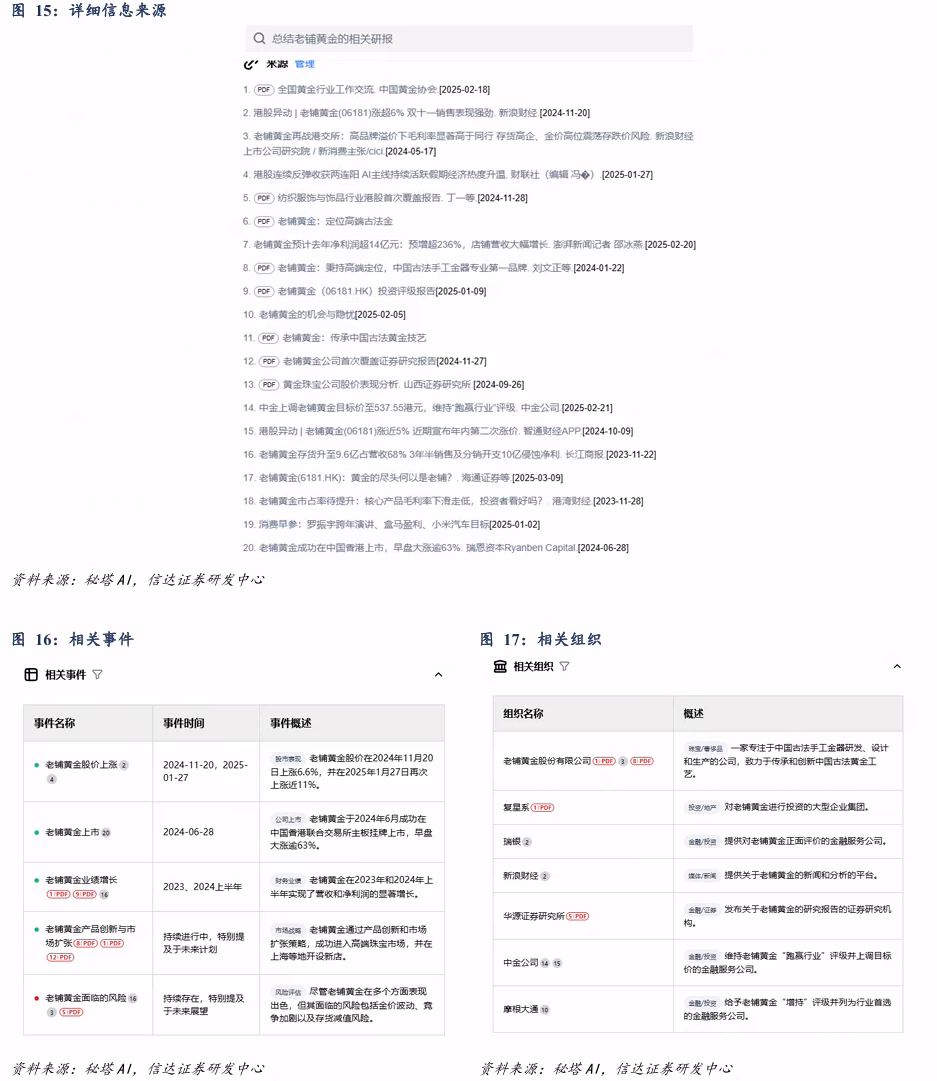

秘塔AI实现学术资源智能检索。秘塔AI集成了DeepSeek-R1深度思考功能,结合学术搜索算法,能够限定搜索范围,在提供精准答案的同时自动给出详细的信息来源、相关事件、相关组织。

-

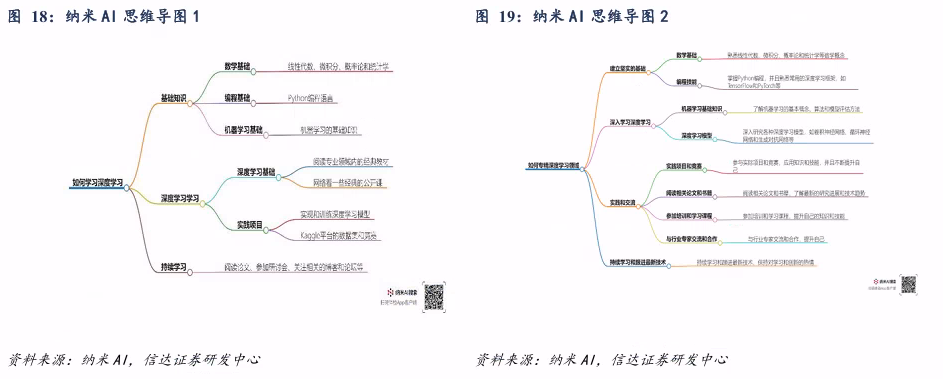

纳米AI实现可视化思维建构。纳米AI能够将复杂问题拆解为可执行任务流,对分步实现的回答能够同时生成思维导图,支持对节点的进一步提问优化。

-

腾讯元宝擅长公众号内容调用。腾讯元宝支持多种文件的上传处理,与微信公众号文章联系紧密,其回答参考资料多为公众号内容。

-

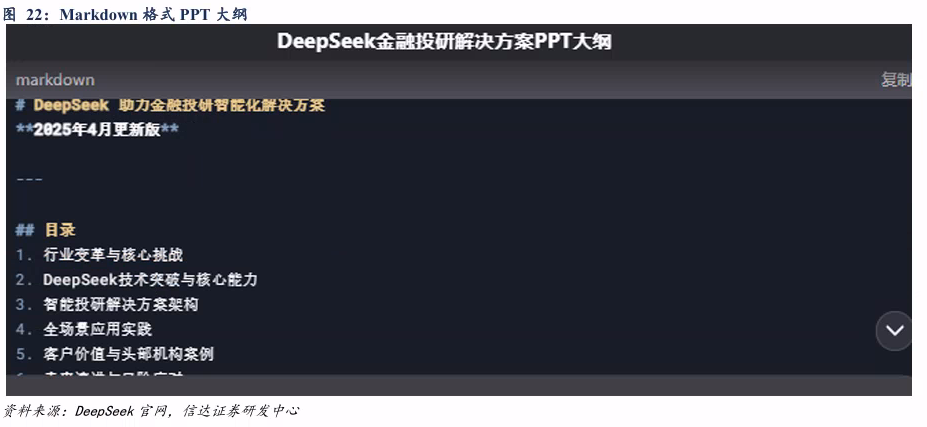

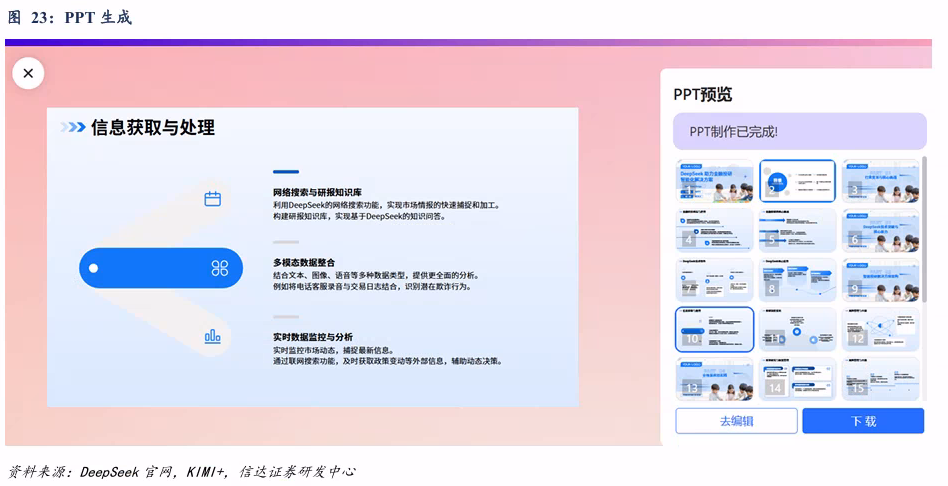

DeepSeek结合Kimi+,能够实现自动生成PPT的功能。通过DeepSeek与Kimi+的跨平台协作,能够实现从大纲到PPT自动流程,而且支持PPT大纲编辑、模板替换等功能。

作为网页版的功能进阶形态,DeepSeek API具有更高的灵活性与可拓展性,为开发者与企业用户提供更具工程价值的接入方案。

-

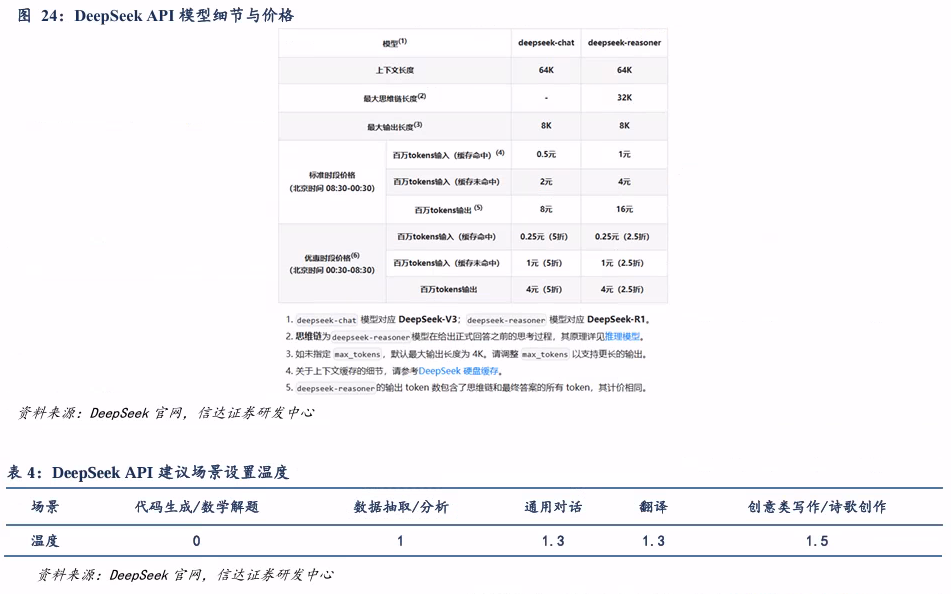

DeepSeek模型可选API丰富,用户可以结合自身需求进行参数的灵活设置。

-

以火山引擎为例使用Deepseek API,通过python或Excel VBA实现相关功能。DeepSeek API支持Python、Excel VBA等多语言调用,实现金融数据处理、行情获取等功能。

本地部署适用于处理敏感数据、需要满足定制化需求、或者需合规性保障的用户,但是对于配置条件有一定的要求。

-

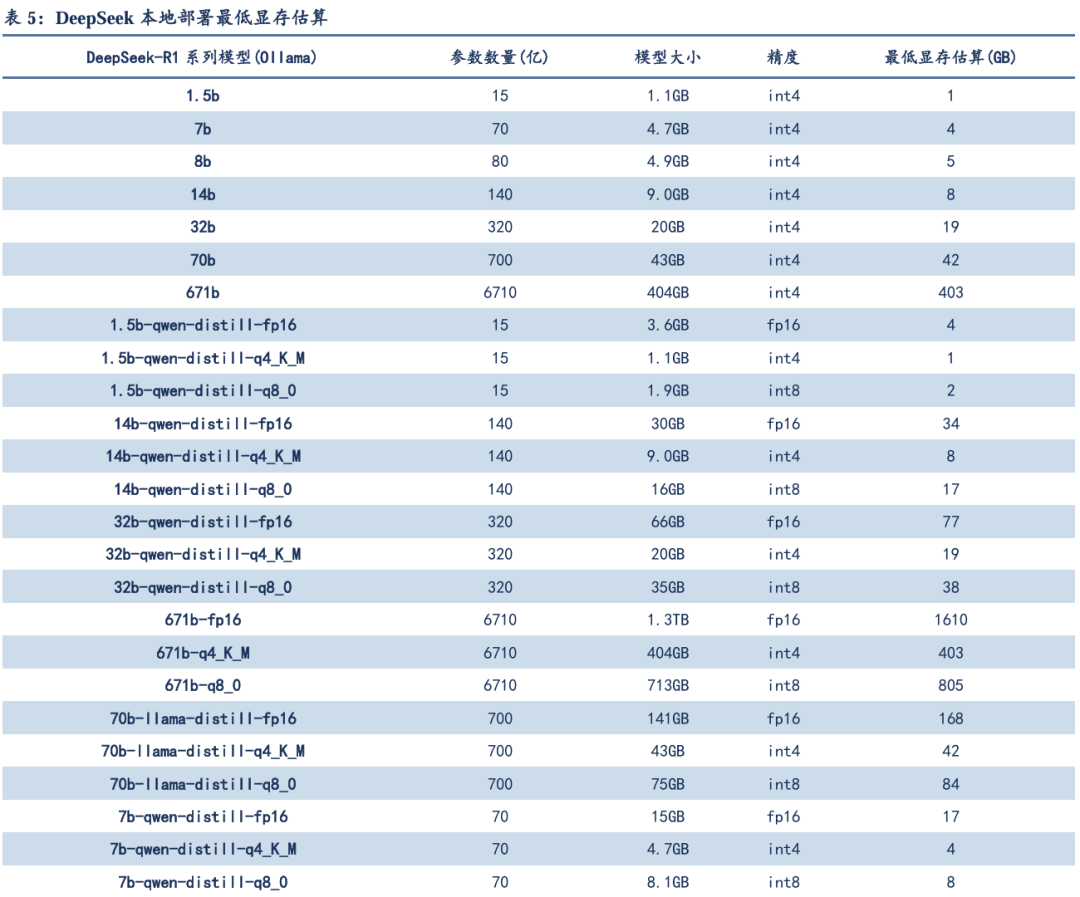

建议有需求的用户结合最低显存估算选择相应模型通过Ollama部署,进一步可以利用浏览器插件实现联网、构建本地知识库等功能。

CherryStudio是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台,支持本地部署大模型与多方API的调用。

-

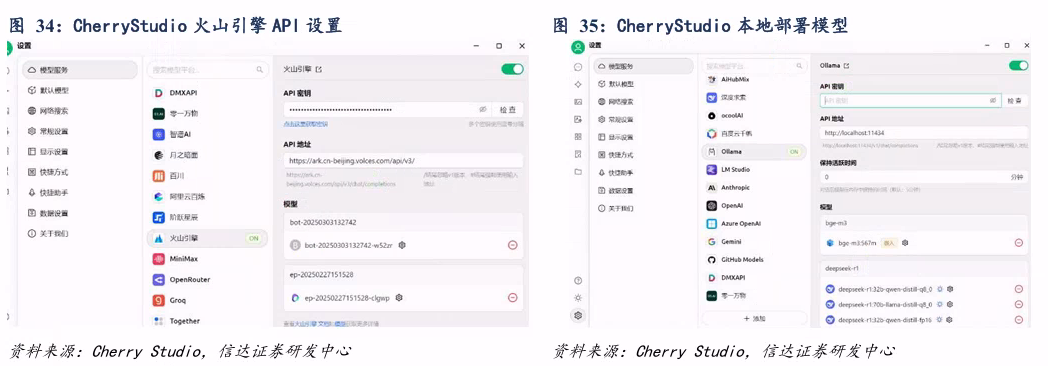

作为深度整合的智能工作平台,用户可以通过CherryStudio调用云端DeepSeek API以及本地部署大模型。

-

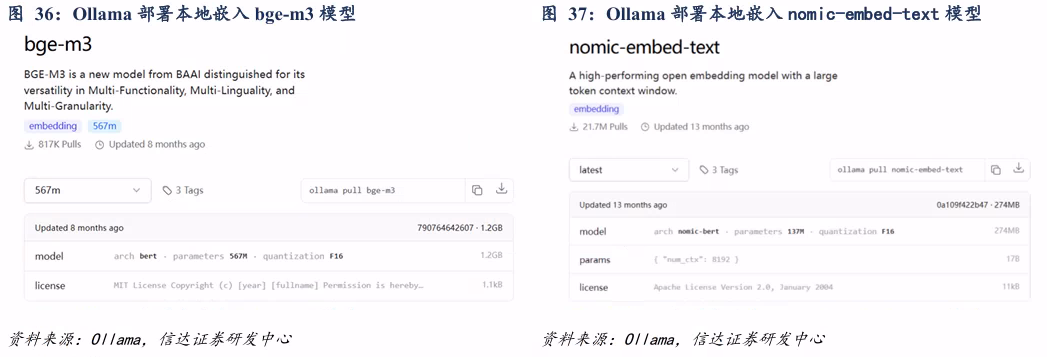

嵌入模型有本地部署与外部API两种配置方式。构建知识库之前,用户可以通过Ollama部署本地嵌入模型,也可以通过外部API配置嵌入模型,文中介绍了通过Jina AI网站获得免费tokens的方式。

-

通过多种文件添加方式,用户可以便捷创建本地知识库,构造多模态智能知识中枢,结合大模型实现不同场景赋能。

风险因素:研究基于历史情况,存在失效及偏差风险;大语言模型输出存在幻觉与随机性,不同模型性能具有差异,产品功能具有时效性局限。

01

DeepSeek开源模型兼具高性能与高性价比

1.1 兼具高性能与高性价比,DeepSeek开源模型引发市场关注

近日,DeepSeek凭借其开源模型引发市场广泛关注,其性能表现对标国际顶尖模型,且通过技术创新与成本控制,DeepSeek已成为当前最具性价比的AI大模型之一,尤其适合金融等垂直领域。

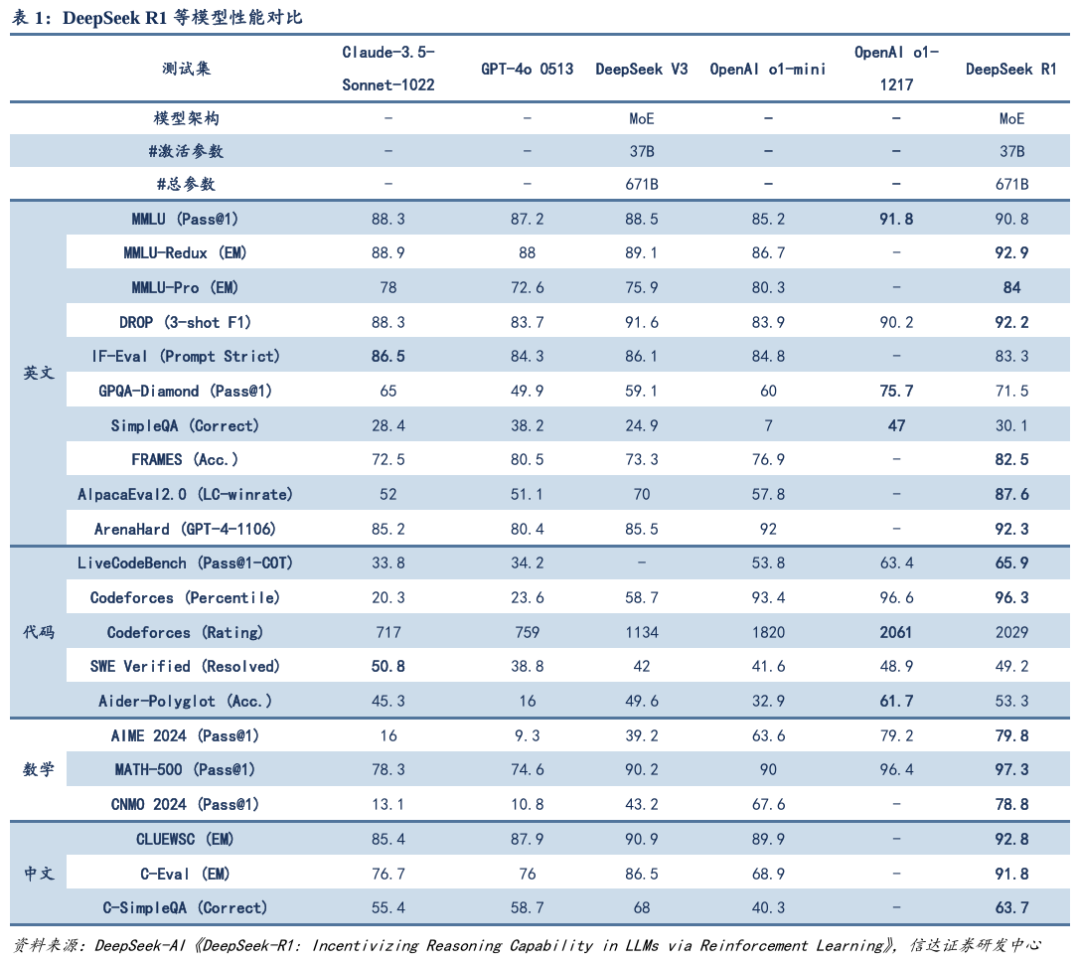

性能对齐海外领军闭源模型:2024年12月,DeepSeek-V3首个版本上线并同步开源。DeepSeek-V3多项评测成绩超越了Qwen2.5-72B和Llama-3.1-405B等其他开源模型,并在性能上和世界顶尖的闭源模型GPT-4o以及Claude-3.5-Sonnet不分伯仲。2025年1月,DeepSeek-R1正式发布并同步开源模型权重。DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有少量标注数据的情况下,大幅提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

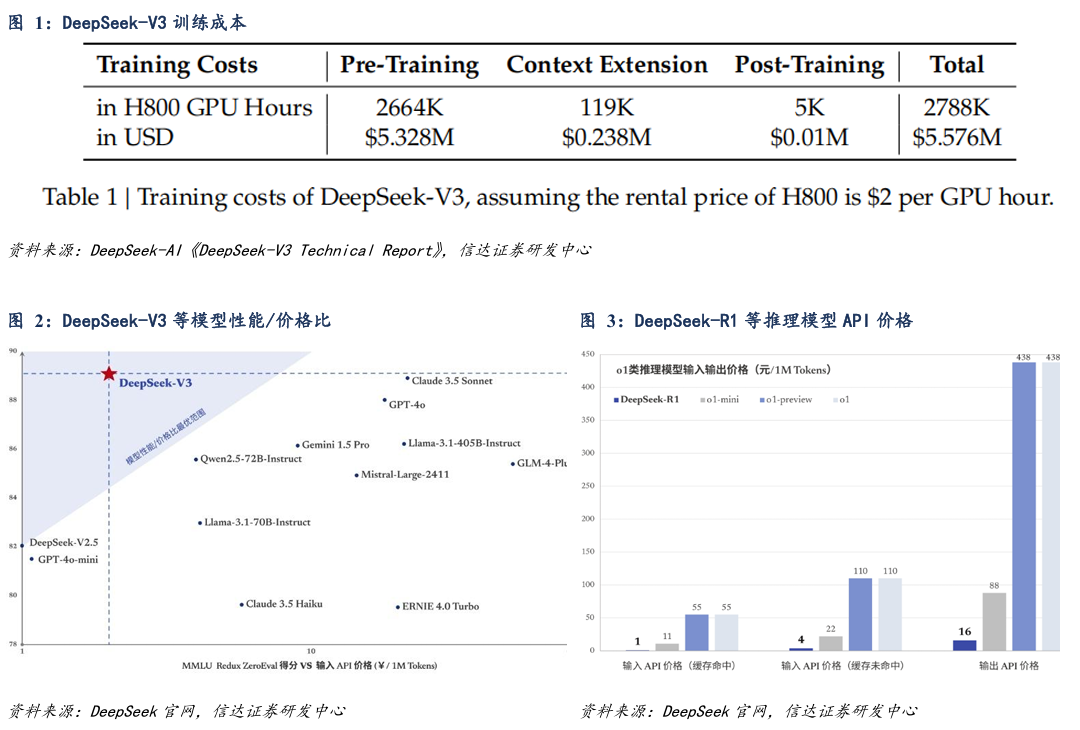

高性价有望重塑行业竞争格局:根据技术文档所述,DeepSeek-V3训练仅使用了278.8万H800 GPU小时,以每小时2美元的租赁价格测算,DeepSeek-V3的训练仅使用了557.6万美金。DeepSeek-V3模型API服务定价为每百万输入tokens0.5元(缓存命中)/2元(缓存未命中),每百万输出 tokens8元,模型性能/价格比相对GPT-4o以及Claude-3.5-Sonnet等模型优势较大。DeepSeek-R1模型API服务价格远低于其他o1类推理模型。凭借其显著性价比优势,DeepSeek有望引领行业竞争迈向新的格局。

模型持续更新,能力全面进阶:2025年3月,DeepSeek-V3-0324发布。根据DeepSeek官网信息,模型能力在多个关键方面均有所提升。(1)推理任务表现提高:新版V3模型借鉴DeepSeek-R1模型训练过程中所使用的强化学习技术,大幅提高了在推理类任务上的表现水平,在数学、代码类相关评测集上取得了超过GPT-4.5的得分成绩;(2)前端开发能力增强:在HTML等代码前端任务上,新版V3模型生成的代码可用性更高,视觉效果也更加美观、富有设计感;(3)中文写作升级:在中文写作任务方面,新版V3模型基于 R1 的写作水平进行了进一步优化,同时特别提升了中长篇文本创作的内容质量;(4)中文搜索能力优化:新版V3模型可以在联网搜索场景下,对于报告生成类指令输出内容更为详实准确、排版更加清晰美观的结果。此外,新版模型在工具调用、角色扮演、问答闲聊等方面也得到了一定幅度的能力提升。如非复杂推理任务,建议使用新版本V3模型。

1.2 DeepSeek-V3:多重技术亮点实现性能与性价比双重突破

优化的模型架构设计、多Token预测目标与FP8混合精度训练等技术亮点是DeepSeek模型如此高性能与高性价比的重要原因。

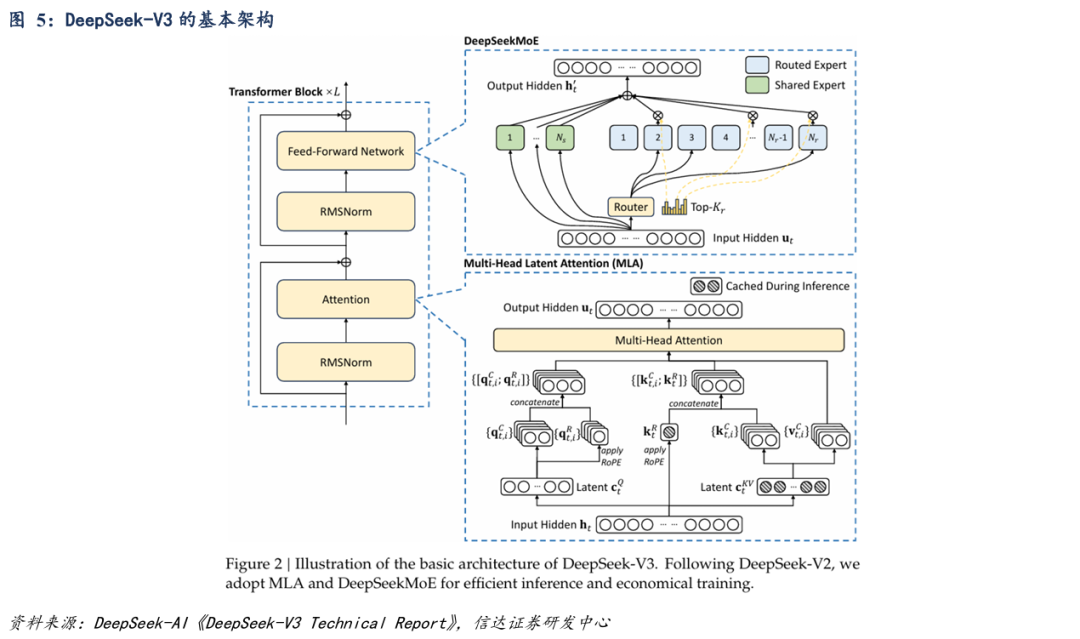

为了实现高效推理与经济训练,DeepSeek-V3基于Transformer框架,采用Multi-Head Latent Attention(MLA) 和DeepSeekMoE技术。

Multi-Head Latend Attention(MLA):在注意力机制中,DeepSeek-V3采用MLA架构,旨在优化Transformer模型中的多头注意力机制的效率,尤其是在推理阶段的内存占用和计算复杂度方面。MLA通过低秩联合压缩键值等技术显著减少了内存占用和计算开销,同时保持了与标准MHA相当的性能。

DeepSeekMoE:在前馈神经网络层,DeepSeek-V3采用DeepSeekMoE架构。对比传统MoE架构,DeepSeekMoE使用更细粒度的专家,并将一些专家隔离为共享专家。为了在负载均衡和模型性能之间取得更好的平衡,DeepSeek开创了一种无辅助损失负载均衡策略,通过动态路由调整与偏差项机制,实现了专家负载的高效均衡。

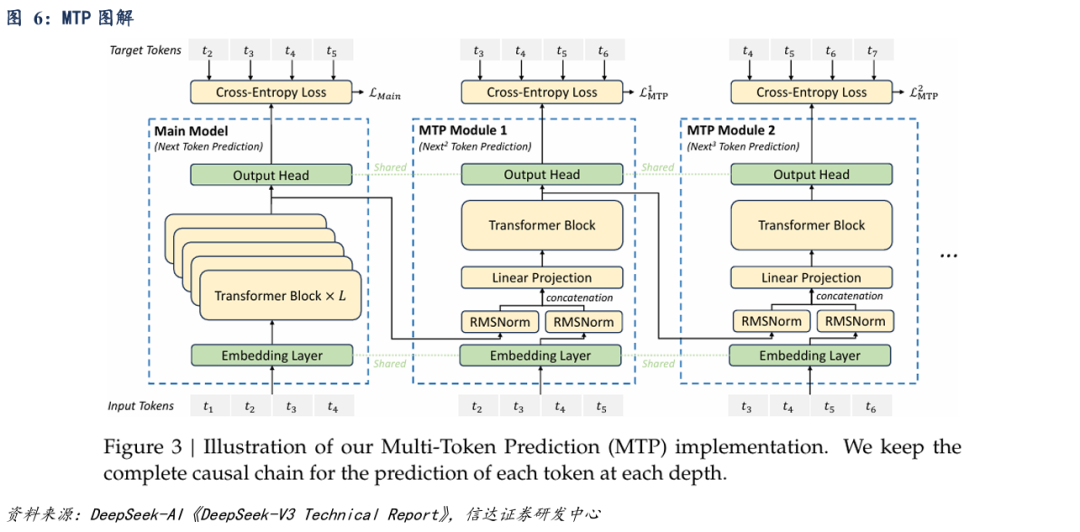

MTP(Multi-Token Prediction):DeepSeek为DeepSeek-V3研究并设定了多Token预测 (MTP) 目标,将预测范围扩展到每个位置的多个未来Token。一方面,MTP 目标使训练信号致密,并可能提高数据效率。另一方面,MTP 可能使模型能够预先规划其表示形式,以便更好地预测未来Token。

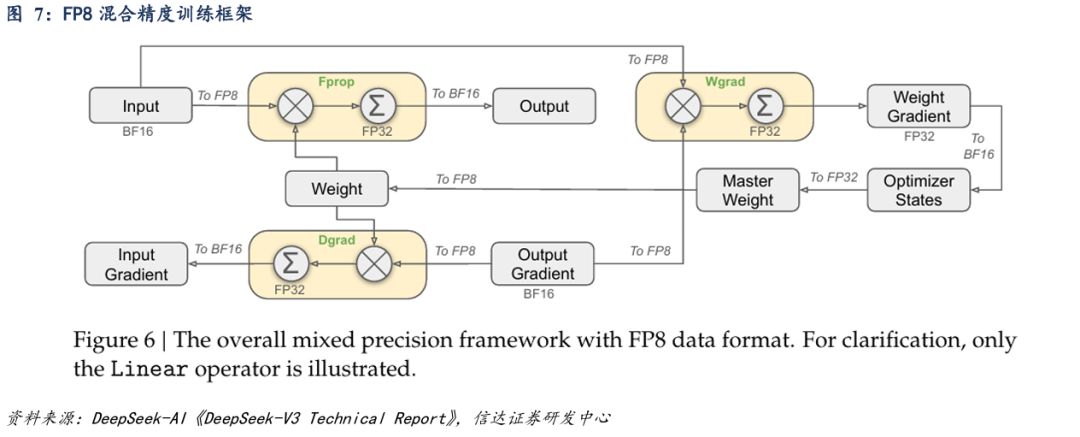

FP8混合精度训练:在预训练中,为了有效扩展FP8格式的动态范围,DeepSeek引入了一种细粒度量化策略。此外,为了进一步减少MoE训练中的内存和通信开销,DeepSeek在FP8中缓存和分派激活,同时在BF16中存储低精度优化器状态。值得注意的是,与BF16基线相比,DeepSeek的FP8训练模型的相对损失误差始终低于0.25%,这一水平远在训练随机性的可接受范围内。

1.3 DeepSeek-R1:基于DeepSeek-V3的强大的推理模型

DeepSeek第一代推理模型DeepSeek-R1-Zero和DeepSeek-R1模型的训练基于DeepSeek-V3-base模型。

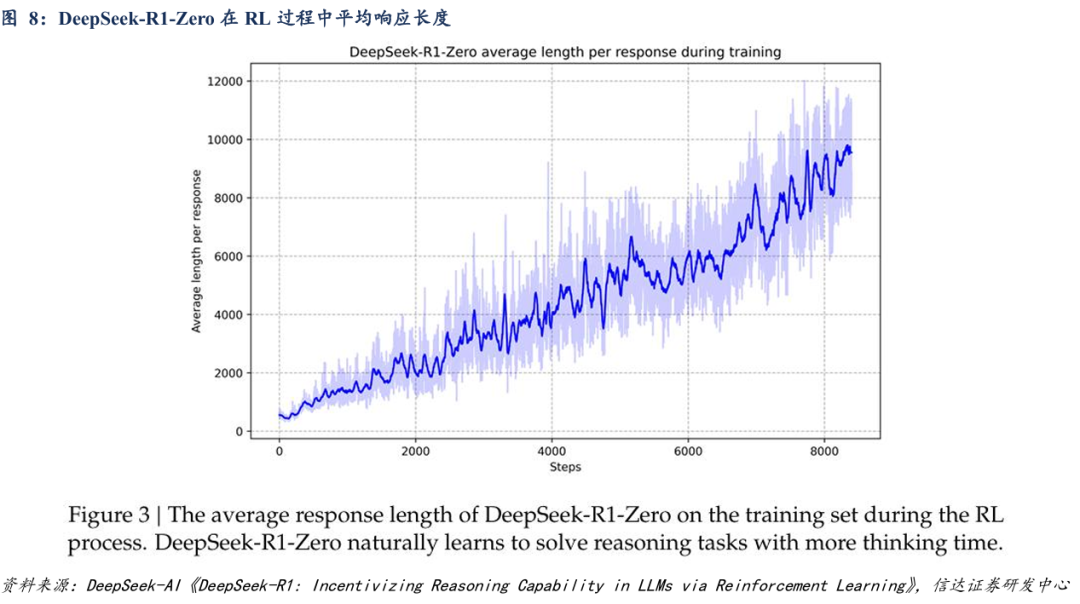

值得注意的是,DeepSeek-R1-Zero模型通过大规模强化学习(RL)突破传统技术框架,无需监督微调(SFT)阶段即展现出了强大的推理能力。DeepSeekR1-Zero 展示了诸如自我验证、反思和生成长思维链(Chain-of-Thought, CoT)的能力,标志着研究界的重要里程碑。值得注意的是,这是第一项验证LLMs推理能力可以纯粹通过 RL 激励的开放研究,而无需 SFT。

为解决可读性差和语言混乱等问题,并进一步提高推理性能,同样基于DeepSeek-V3-base模型,DeepSeek团队结合多阶段强化学习以及监督微调,最终训练出强大的DeepSeek-R1模型。

DeepSeek-R1蒸馏模型:小模型也可以很强大。使用DeepSeek-R1生成的推理数据,DeepSeek团队微调了几种在研究界广泛使用的密集模型。仅采用监督微调(SFT),蒸馏方法显著增强了小模型的推理能力。

02

网页对话实现智能服务体系

2.1 网页版DeepSeek访问渠道丰富

依托于其出色的语义理解能力,DeepSeek能构建优秀的长思维链,生成连贯、自然且富有逻辑性的文本。

除DeepSeek官网与官方APP以外,用户还可以通过第三方平台渠道体验DeepSeek模型。

借助DeepSeek强大的自然语言处理能力,用户通过对话交互即可实现不同场景下的智能协作生态。

2.2 DeepSeek官网实现智能问答与文档解析功能

通过DeepSeek处理新闻与舆情分析、文本综述等相关工作:借助DeepSeek官方对话网页(https://chat.deepseek.com/),通过实时监控社交媒体、新闻平台等,快速收集相关文本数据, 进行新闻和舆情分析。官网对话框下方两个可选项分别代表:(1)选中“深度思考(R1)”即为DeepSeek-R1模型,否则为DeepSeek-V3模型;(2)选中“联网搜索”能够获得时效性较强的网络信息。

通过DeepSeek进行文件处理工作:DeepSeek官网支持多种文件类型,可以对上传文件进行处理,文件上传限制为单个文件不超过100MB、单次最多50个文件。

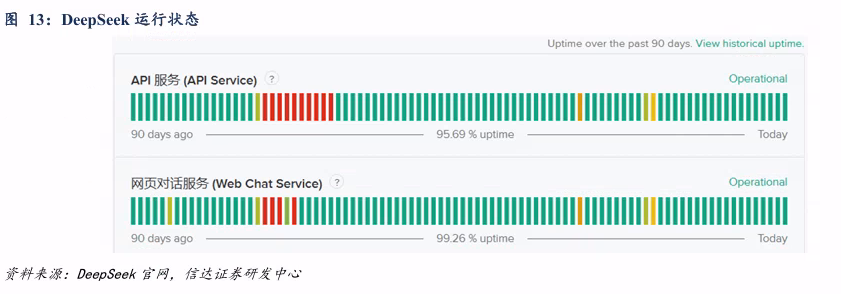

受用户量、算力需求激增等因素影响。DeepSeek官网与API在过去一段时间内多次出现性能异常事件。

2.3 秘塔AI实现学术资源智能检索

秘塔AI(https://metaso.cn/)嵌入DeepSeek-R1深度思考功能,不仅可以限定搜索范围,例如学术中英文库与中文库,而且可以给出翔实的来源,降低来自大模型生成的幻觉。用户可以根据自身需求选择“简洁/深入/研究”模式。

利用秘塔AI搜索相关标的研报信息:选择DeepSeek-R1模型,结合用户自身需求选择不同模式,在给出相应回答的同时,秘塔AI还会给出详细的信息来源、相关事件、相关组织。

在文件处理方面,秘塔AI网页目前仅支持图片上传。

2.4 纳米AI实现可视化思维建构

纳米AI(https://www.n.cn/)是360旗下的AI助手产品,嵌入DeepSeek-R1-联网671B模型。

通过网页的对话,纳米AI不仅可以给出对话的答案,而且能够对原文选择不同风格进行改写。

纳米AI在给出回答的同时生成思维导图,且对于回答原文或者思维导图的任一节点,都能通过鼠标点击,生成进一步的答案。

2.5 腾讯元宝擅长公众号内容调用

腾讯元宝( https://yuanbao.tencent.com/chat/ )嵌入了DeepSeek-R1模型。腾讯元宝可以通过微信登录,使用相对方便,支持多种文件的上传处理。在使用过程中,我们发现腾讯元宝与微信公众号文章联系紧密,其回答参考资料多为公众号内容。

2.6 DeepSeek结合Kimi+实现自动化办公输出

以“你是一个金融分析师,需要结合当前情况,完成一个DeepSeek助力金融投研的PPT,请生成一个PPT大纲,并以Markdown格式输出”的Prompt为例,DeepSeek网页生成相应Markdown格式的大纲并复制。

访问探索 Kimi+(https://kimi.moonshot.cn/kimiplus-square),点击PPT助手,将复制内容粘贴至对话框,Kimi+生成PPT内容,点击一键生成PPT并选择模板生成,我们可以获得相应的PPT。

网页版DeepSeek更倾向于直接的用户交互,适合轻量级需求的个人用户,用户使用成本较低。DeepSeek开源模型为第三方平台嵌入大模型提供便利,网页版DeepSeek的访问渠道日渐丰富。

03

DeepSeek API实现智能中枢构建

3.1 DeepSeek模型可选API丰富

相比网页版DeepSeek,DeepSeek API具有更高的灵活性,可拓展性更强,成本相对较高,更适合开发者或者企业用户。在通过API接口直接调用大模型的过程中,用户可以根据自身需求对参数进行不同的设置。

除DeepSeek官网提供的API以外,字节旗下火山引擎、腾讯云、阿里云百炼、硅基流动、国家超算平台均提供了DeepSeek R1接口。

根据DeepSeek官网提供信息:DeepSeek-V3与DeepSeek-R1上下文长度为64K,最大输出长度为8K,如未指定max_tokens,默认最大输出长度为4K。DeepSeek API的temperature参数默认为1.0,用户可根据自身需求对温度进行设置。

3.2 以火山引擎为例使用Deepseek API

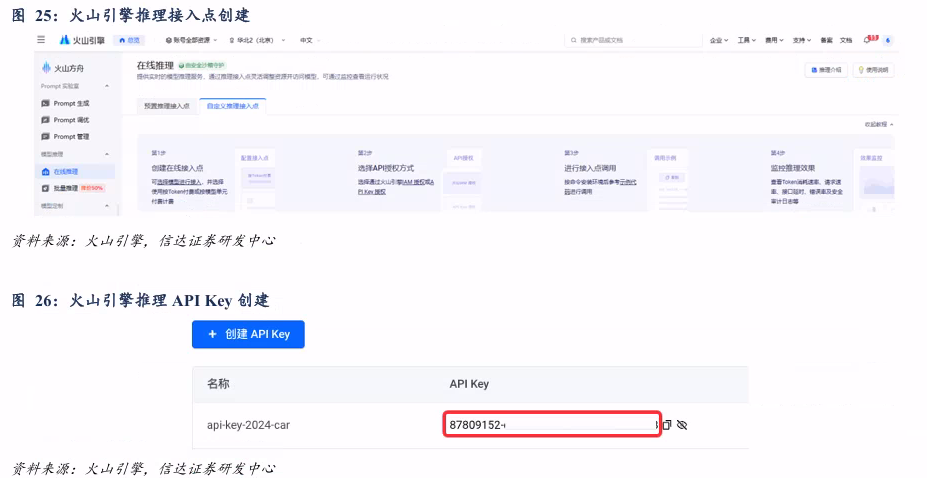

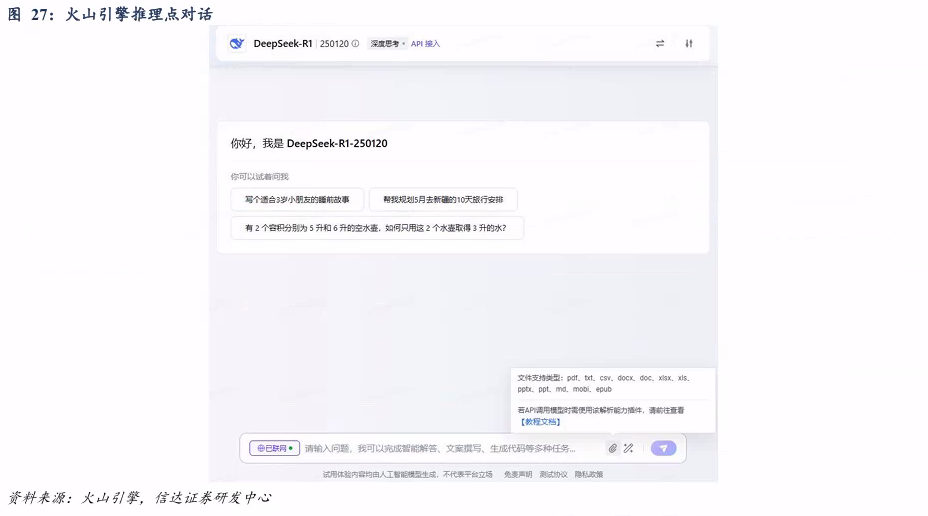

访问火山方舟-火山引擎(https://console.volcengine.com/ark),注册后完成实名制认证。在左侧中模型推理选择在线推理,创建推理接入点(首次需开通模型);点击确认接入进行API调用(首次需创建API Key)。

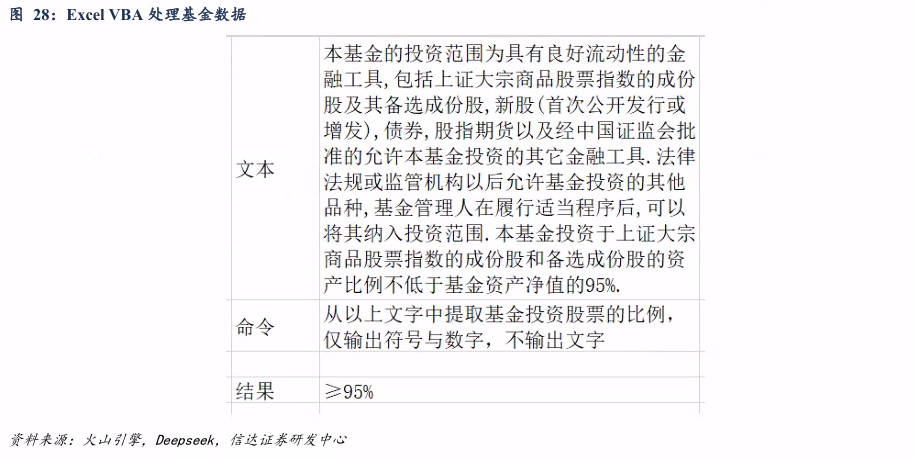

点击推理接入点操作区的体验,我们可以获得与DeepSeek网页版相似的对话页面,且支持多种文件上传。

3.3 DeepSeek API接入Excel与Python

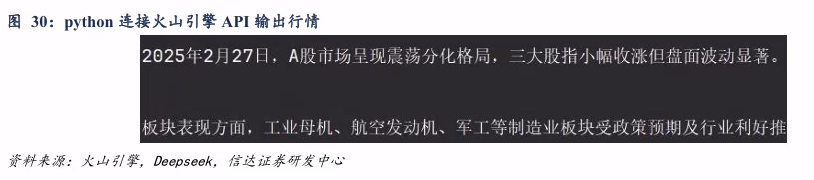

通过火山引擎API key及模型ID,用户可以用python或Excel VBA访问Deepseek实现相关功能。

利用火山引擎应用(Bot) API的联网插件实现联网功能:零代码创建应用,打开联网内容插件,可选联网资源类型包含联网资源、头条资源、抖音资源、墨迹天气,其中联网资源每月免费额度是2万次。

04

DeepSeek 本地部署条件与功能

4.1 DeepSeek本地部署GPU估算

本地部署大模型具有保证数据隐私与安全、满足灵活的定制化需求、避免持续付费、减少网络传输延迟、离线依然可用等优势。本地部署适用于处理敏感数据、需要满足定制化需求、或者需合规性保障的用户,但是对于配置条件需要满足一定的要求。推荐通过Ollama进行本地大模型的部署,支持一键安装和模型管理,提供命令行及WebUI界面,适合快速部署。

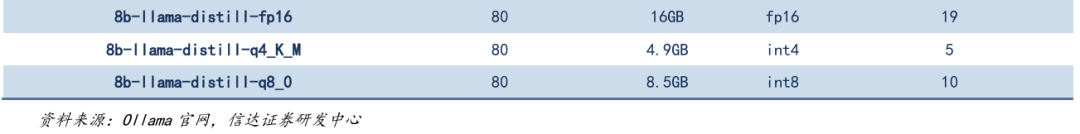

Ollama提供的Deepseek-R1为量化版本,通过降低数值精度来减少模型的存储空间按以及运行所需资源。

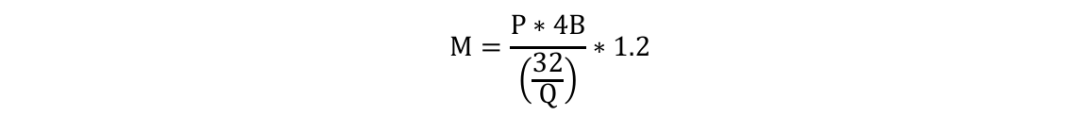

我们通过参数数量、位宽与参数使用字节来估算模型运行的显存:

其中,P为参数数量,Q为参数位宽,4B为每个参数使用字节。

4.2 通过Ollama进行DeepSeek本地部署

下载安装Ollama( https://ollama.com/download ),默认安装于C盘,可以通过“OllamaSetup.exe /DIR=D:\Ollama”指令安装于其他指定位置。

Ollama安装要求:Win10以上系统,4GB以上空间(安装Ollama后,还需要额外的空间来存储大型语言模型,这些模型的大小可能从几十GB到几百GB不等)。

在Ollama官网(https://ollama.com)搜索相应的大模型,如deepseek-r1,可以获得一系列模型,结合模型大小、本地条件等因素选择相应模型进行本地部署。

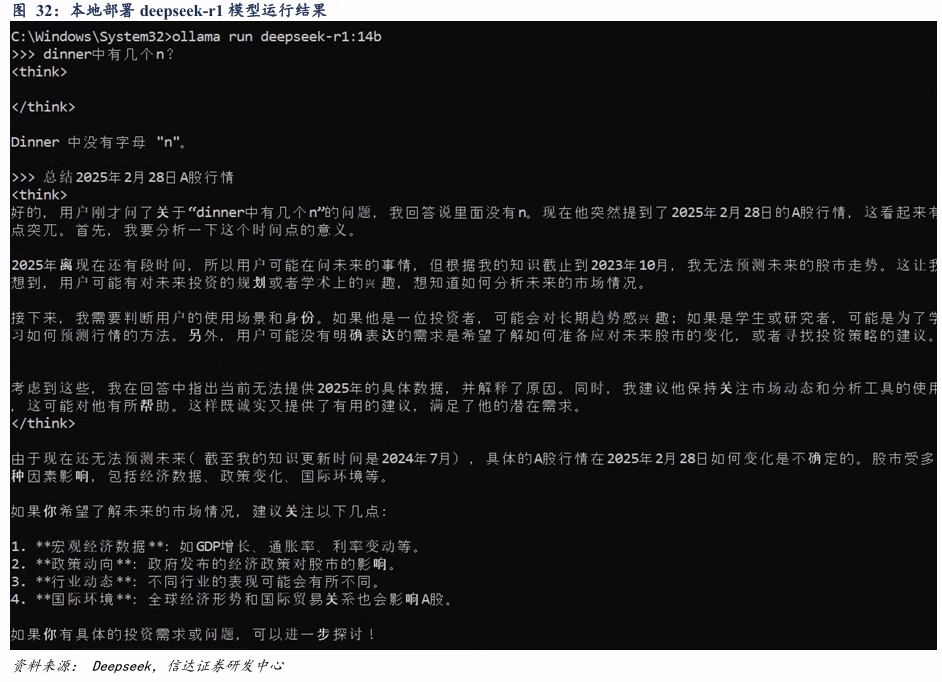

模型下载:以deepseek-r1:14b模型为例,复制模型右侧代码(如:ollama run deepseek-r1:14b),在ollama运行的情况下,粘贴在cmd中部署指定模型。在未更新系统变量的情况下,模型下载于默认位置(如“C:\Users\XXX\.ollama\models”),否则下载于指定位置。

模型运行:以deepseek-r1:14b模型为例,与拉取模型的操作相同(如:ollama run deepseek-r1:14b),在ollama运行的情况下,粘贴在CMD中可与部署模型直接进行对话。可以看到,本地部署有思考过程,但是相对671B版本不够“聪明”,且没有联网。

4.3 利用浏览器插件实现联网、构建本地知识库

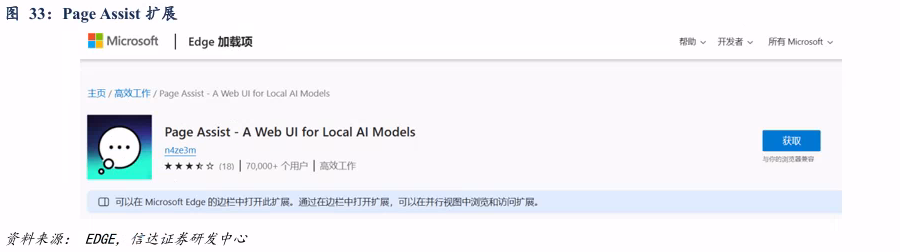

添加Page Assist浏览器插件:在Edge扩展商店搜索Page Assist,点击获取,安装Page Assist扩展。

利用Page Assist插件能够实现类似豆包插件的网页互动功能,进一步可以对插件设置联网功能以及构建本地知识库。

05

利用交互应用软件构建知识库

5.1 Cherry Studio的使用方式

Cherry Studio(https://docs.cherry-ai.com/cherrystudio/download) 是一款集多模型对话、知识库管理、AI绘画、翻译等功能于一体的全能AI助手平台,支持本地部署模型与多平台API的调用。

5.2 Cherry Studio嵌入模型配置

在构建知识库之前,我们需要配置嵌入模型,配置方式有本地部署与外部API两种。

通过Ollama部署嵌入模型bge-m3或者nomic-embed-text模型。下载方式与前述模型相同:搜索相应模型,复制右侧代码下载模型。通过Ollama部署的模型需要在模型服务中打开Ollama,点击下方管理,查找嵌入模型,找到需要的模型并添加。

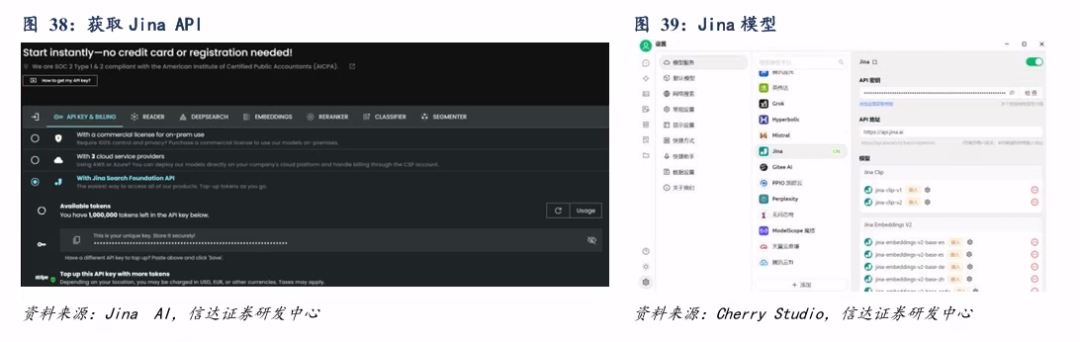

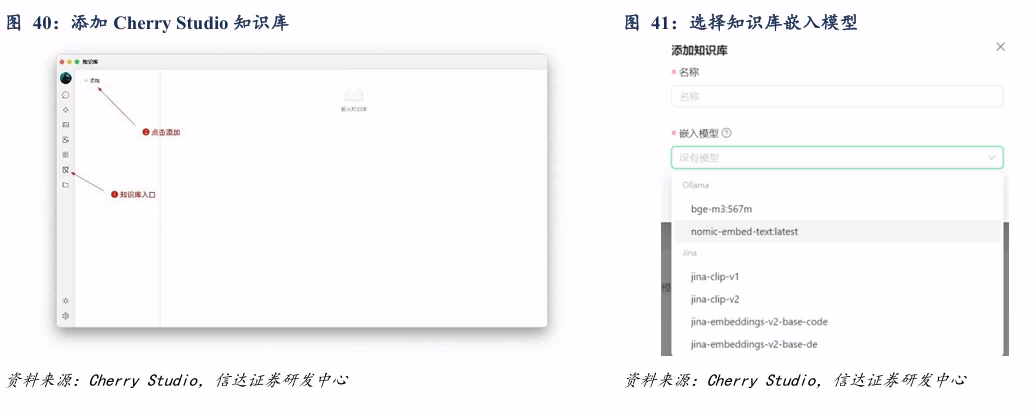

通过Jina AI网站获得嵌入模型的Api key。访问Jina AI官方网站(https://jina.ai/),无需注册即可直接复制Api key并获得免费的tokens。在模型服务中打开Jina,粘贴Api key即获得相应Jina模型。

5.3 Cherry Studio构建本地知识库

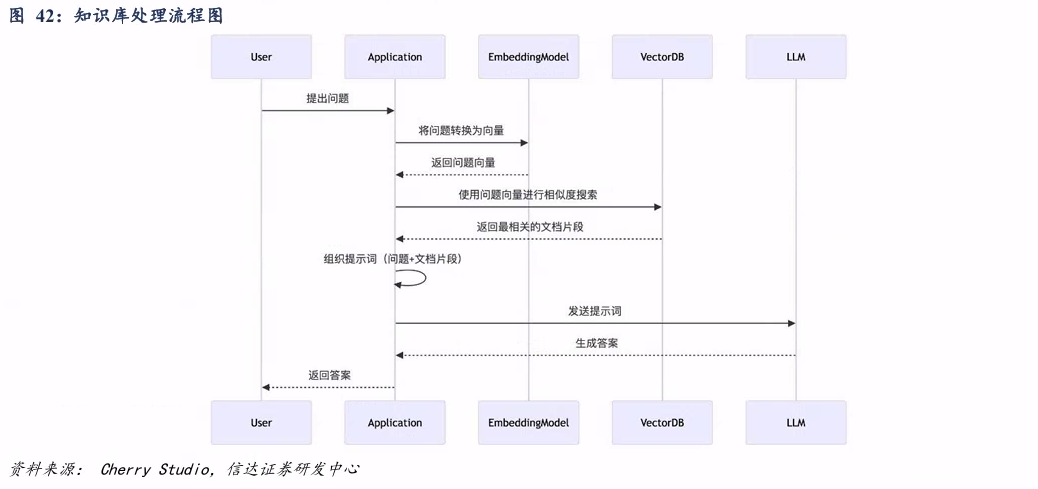

创建知识库的同时需选定嵌入模型:在Cherry Studio左侧工具栏,点击知识库图标,即可进入管理页面;点击添加创建知识库;输入知识库的名称并添加嵌入模型,即可完成创建。

如果对数据隐私有要求,建议使用本地嵌入数据库和本地大语言模型。

CherryStudio支持多种方式添加文件至知识库,包括文件拖拽、文件夹目录、网址链接、站点地图、纯文本笔记;支持的文件格式包括pdf,docx,pptx,xlsx,txt,md,mdx等。文件添加后系统会自动进行向量化处理,当显示完成时(绿色 ✓),代表向量化已完成。

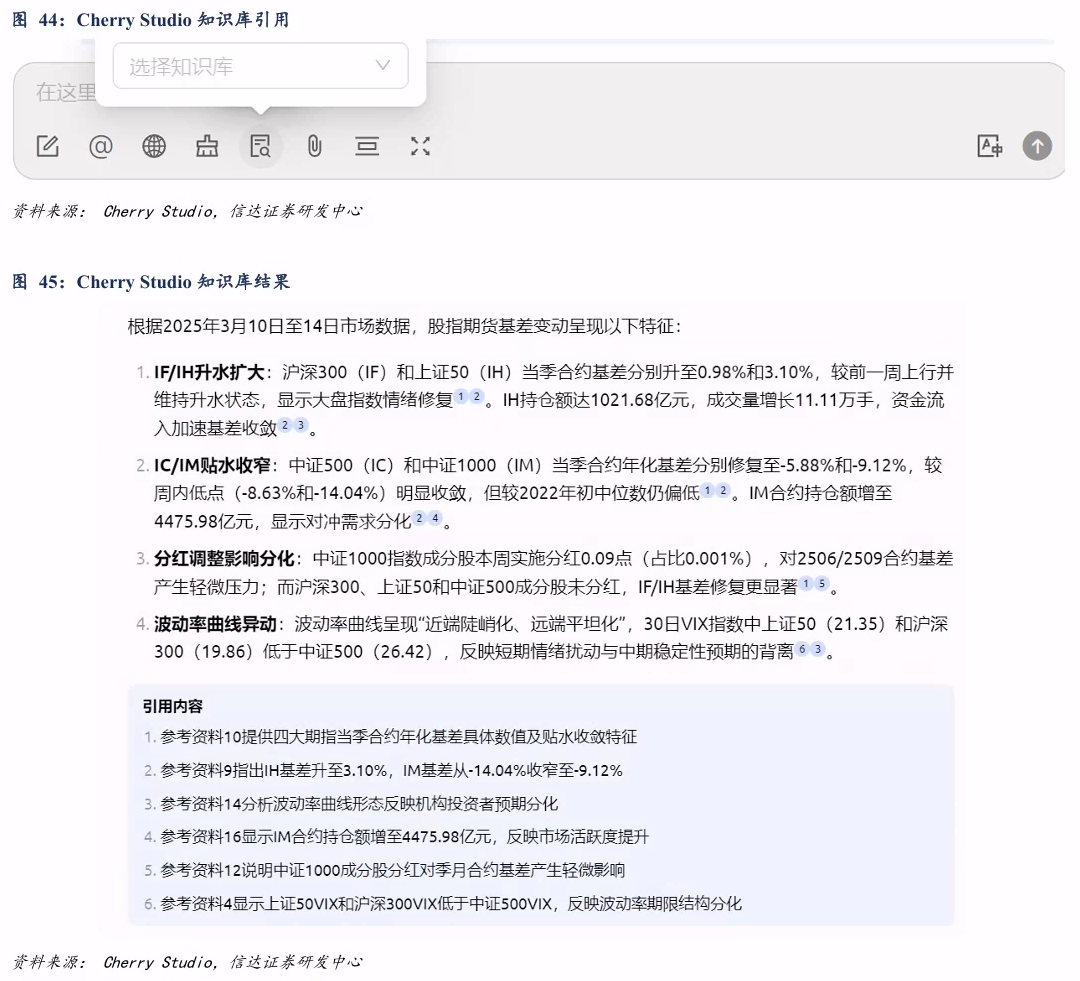

知识库文件的处理流程如下:当文档被添加到Cherry Studio知识库之后,文件会被切分为若干个片段,嵌入模型会对这些片段进行处理。当用户使用大模型进行问答的时候,查询和问题相关的文本片段,一并交给大语言模型处理。

Cherry Studio知识库选项支持1-30个文档,经过我们本地构建知识库的测试可知,文档数量较少时,知识库表现相对较好。

在知识库创建完成后,用户可以通过知识库下方“搜索知识库”进行查询,也可以在对话工具栏选中所需的知识库,输入问题获得引用知识库生成的回复。

风险因素:研究基于历史情况,存在失效及偏差风险;大语言模型输出存在幻觉与随机性,不同模型性能具有差异,产品功能具有时效性局限。

本文源自报告《深度学习揭秘系列之四:DeepSeek大模型如何助力投研?》

报告时间:2025年4月23日

转载请注明:可思数据 » 深度学习揭秘系列之四:DeepSeek大模型如何助力投研?

免责声明:本站来源的信息均由网友自主投稿和发布、编辑整理上传,或转载于第三方平台,对此类作品本站仅提供交流平台,不为其版权负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本站联系,我们将及时更正、删除,谢谢。联系邮箱:elon368@sina.com