网状化学研究分子构筑单元的连接,形成金属-有机框架(MOFs)和共价有机框架(COFs)等晶态扩展结构。大型语言模型(LLMs)作为生成式人工智能,可助力研究者从文献中提取知识、设计材料、收集与解析实验数据,从而加速科学发现。本综述探讨LLMs在研究中的应用,包括提示工程、知识与工具增强及微调优化。我们讨论如何构建“化学感知”模型,使其适配特定任务,并融入网状化学实践,将传统的“合成-表征-应用”经验驱动流程转化为基于合成-结构-性质-性能关系的发现循环。此外,我们探讨模块化LLM智能体如何嵌入多智能体实验系统(如自驱动机器人实验室)以优化繁重任务、辅助化学家,并降低LLMs在晶体生长等复杂问题中的应用门槛。本研究为计算与实验化学家提供洞见,助力LLMs在网状化学及更广泛材料科学领域的材料发现。

背景

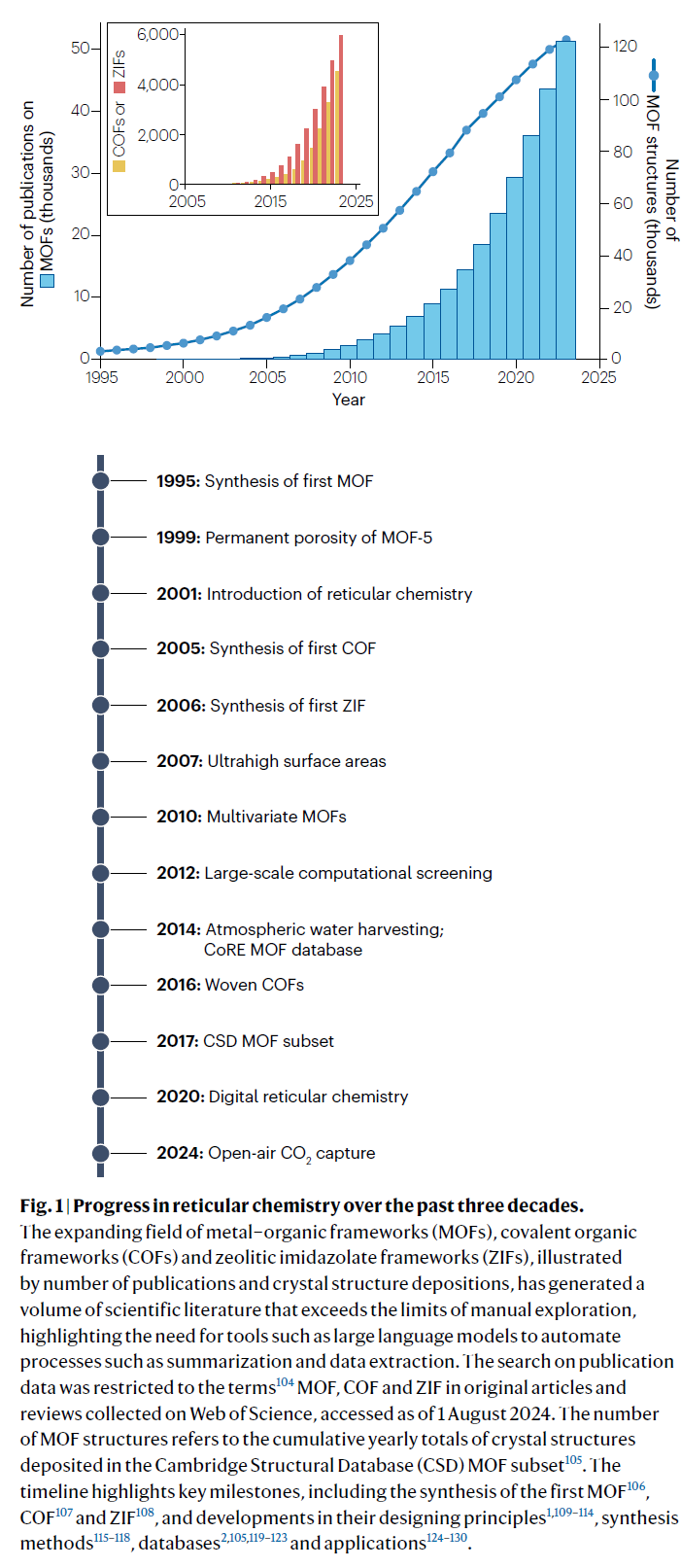

网状化学通过强键连接分子构筑单元,构筑晶态扩展结构,为材料设计与发现提供广阔空间。其高度可调的构筑单元已催生大量网状化合物,包括金属-有机框架(MOFs)、共价有机框架(COFs)、沸石咪唑骨架(ZIFs)及分子编织。然而,这一几乎无限的设计空间仍未被充分探索。传统的试错法依赖专业知识,难以扩展,限制了研究进展。

近年来,生成式人工智能(AI)迅速发展,其中大型语言模型(LLMs)因其自然语言处理、化学知识整合及工具应用能力,吸引了化学与材料领域的关注。LLMs可自适应提取文献化学数据,自动化合成流程,助力解决气候变化、清洁能源、空气与水污染及健康问题,提升实验效率。然而,对于缺乏经验的化学家而言,如何优化LLM代理并融入现有工作流仍具挑战。

本综述探讨LLMs如何革新网状化学,尤其是对合成-结构-性质-性能关系的理解,从而加速材料发现。我们介绍LLMs的基础应用技术,解析其在实验室的潜在价值,旨在激发创新应用,降低技术壁垒,为希望探索LLMs潜力的计算与实验化学家提供关键洞见。

大型语言模型基础

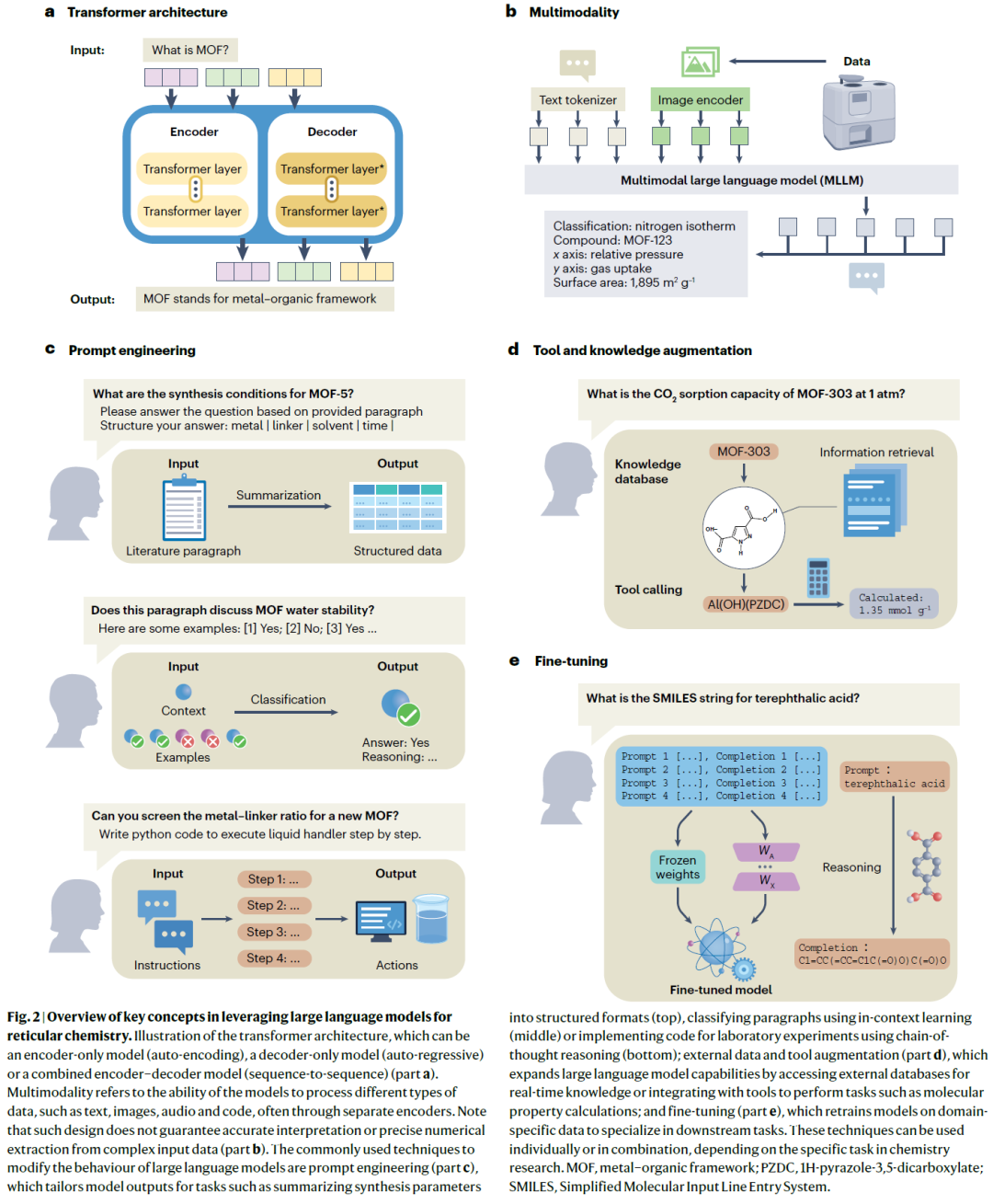

大型语言模型(LLMs),如GPT、Claude、Gemini和LLaMA系列,是基于变换器架构的深度神经网络,具备亿级参数,能够识别并生成类人语言模式。LLMs可通过多模态扩展处理文本、图像、视频等数据,拓展其应用领域。本文聚焦如何优化LLMs,使其适应网状化学任务。

提示工程

提示工程通过优化输入指令,提高LLMs的响应质量,降低对编程的依赖。例如,指令“请将以下合成条件整理成表格”可引导模型提取关键信息并生成结构化输出。

-

减少幻觉:要求模型仅基于提供的文本回答,避免生成虚假信息。

-

提供详细指令:用明确参数(如“金属-配体比、反应温度”)替代模糊描述。

-

指定输出格式:预设模板,确保结果一致,便于后续处理。

此外,可通过少样本学习提供示例提高分类和提取精度,或采用链式思维分解复杂任务,如自动化合成流程。

增强技术

增强技术分为数据增强与工具增强,拓展LLMs能力。

-

数据增强:结合检索增强生成(RAG)访问最新文献、数据库,提升准确性并减少幻觉。

-

工具增强:LLMs可调用外部计算工具,如分子质量计算、结构转换、合成规划等,提高专业任务的执行能力。

微调优化

微调LLMs可通过特定数据集(如合成条件、材料性质等)调整模型权重,使其适应特定任务。常见方法包括全量微调、指令微调和参数高效微调。相比提示工程和增强技术,微调可让模型学习更深层次的模式,提高任务适配性,但也更依赖高质量数据与计算资源。对于初学者,可使用API支持的微调方式,以降低技术门槛。

综合来看,LLMs结合提示优化、增强工具及微调,可极大提升其在网状化学中的应用潜力,加速材料发现进程。

实践场景与工作流程

在掌握了LLMs的任务优化方法后,下一步是将其应用于网状化学研究。以下案例展示了数据挖掘、材料设计及优化方面的具体实践经验。

数据挖掘

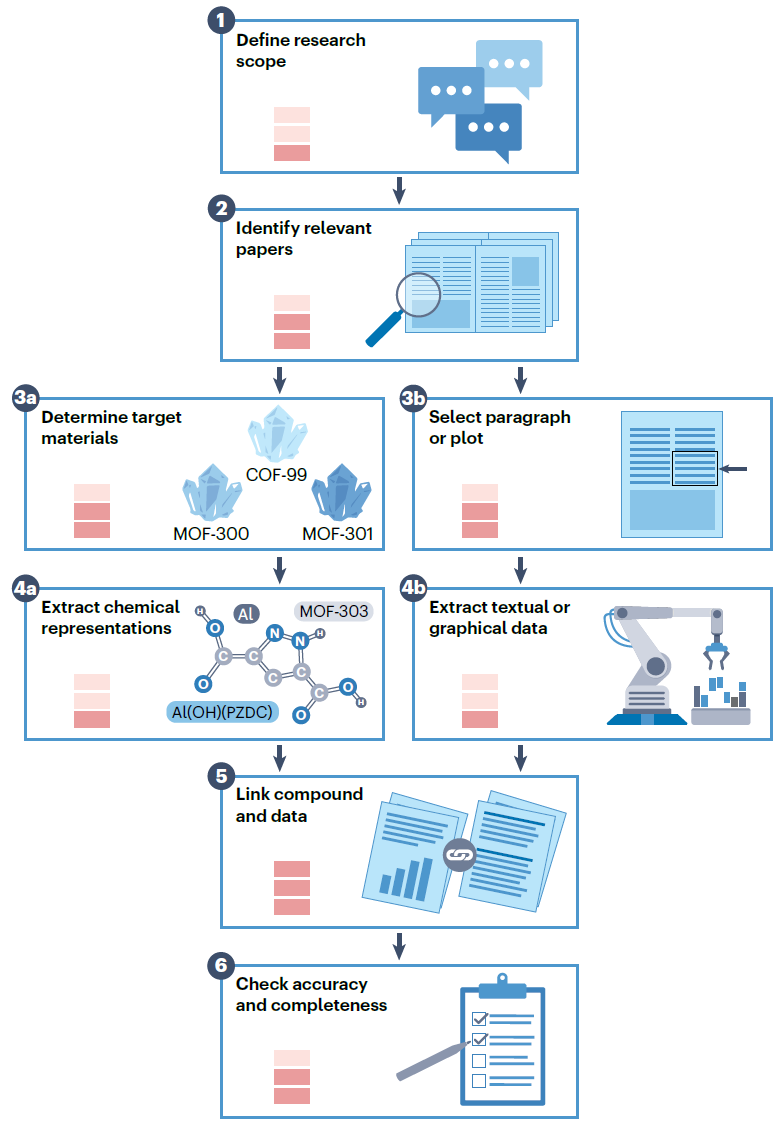

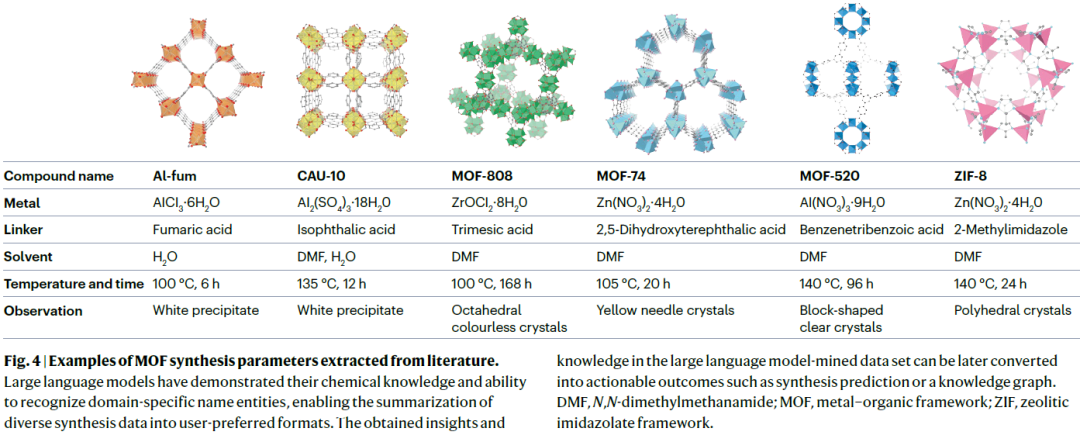

网状化学研究者需要从复杂文本中提取知识,以理解合成-结构-性质关系。传统数据整理依赖人工标注或编程,难以扩展。LLMs可自动执行文献筛选、语义分析、命名实体识别及后处理,实现高效数据挖掘。例如,在提取MOF合成参数时,LLMs可识别相关文献,抽取金属、配体、溶剂、反应时间和温度等信息,并输出结构化数据。此外,多模态LLMs还能解析图像,如判别热重分析或氮吸附等实验数据。

尽管LLMs可标准化部分数据,但不同文献中的命名差异(如MOF-74 vs. CPO-27)仍构成挑战。未来,可通过多代理LLM系统或微调优化,提升数据一致性。同时,LLMs可辅助数据处理,如分子名称转换、计算浓度、检测异常值等,减少实验人员负担。

网状框架设计

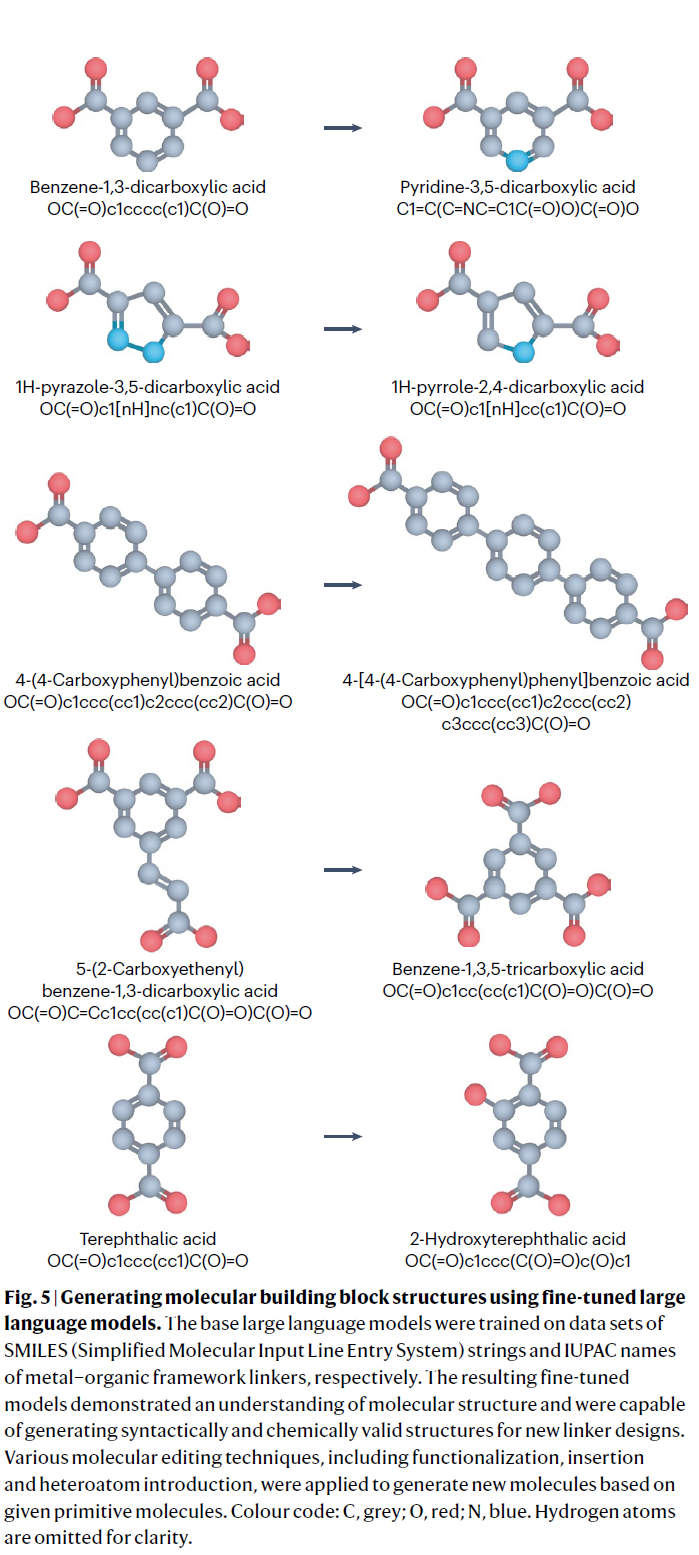

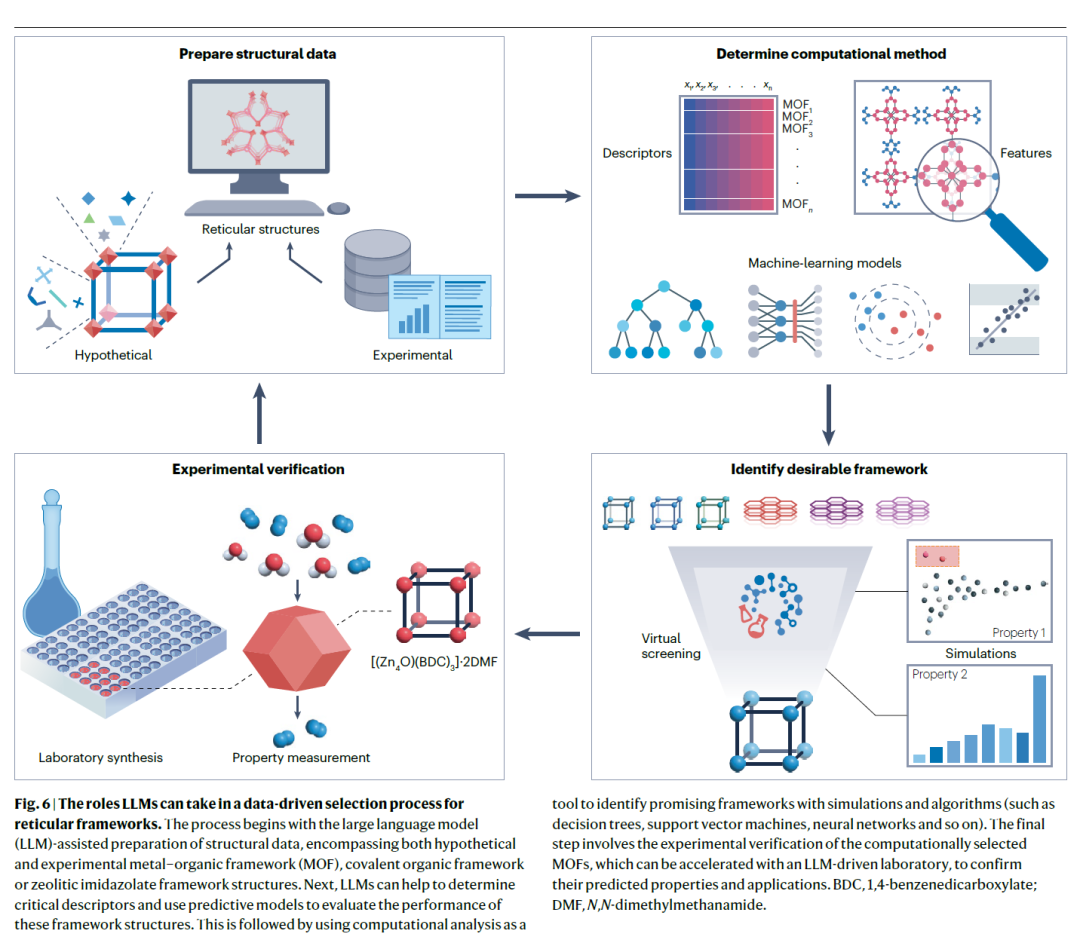

由于网状框架的结构变体几乎无限,人工穷举十分困难。LLMs作为生成式AI,可快速生成新型构筑单元及框架,并结合ML评估其合成可行性与性质,缩小筛选范围,加速材料发现。

研究表明,LLMs可基于MOF构筑单元数据集,学习有机配体编辑规则(如官能团修饰、分子骨架调整、杂原子引入),生成合理分子。实验表明,经过微调的GPT-3.5模型在MOF配体生成任务上的准确率大幅提高。此外,LLMs还能辅助晶体结构文件(CIFs)生成,推动高通量计算筛选。

在材料性质预测方面,LLMs可通过工具增强与计算软件(如Zeo++、PoreBlazer、RASPA)联动,分析孔隙率、气体吸附、热稳定性等指标。未来,LLMs可整合各类ML模型,实现材料设计、筛选、优化的闭环。

合成探索与自动化

结晶是网状化学研究的核心,决定了材料表征和质量。然而,合成条件的微小变化可能显著影响结晶,导致筛选过程漫长且经验依赖性强。LLMs可在以下方面优化合成流程:

-

实验指导:提供实验方案,预测合成结果,并结合人机迭代调整策略。研究表明,LLMs可协助文献调研、配体合成、MOF筛选等任务,提升研究效率。

-

预测合成结果:结合ML模型,预测特定条件下的框架形成概率,从而优化参数,减少实验负担。例如,基于GPT-4开发的ML模型已实现>90%的单晶形成预测准确率。

-

自动化实验:LLMs可集成实验室机器人,实现高通量合成筛选。例如,多代理LLM系统可协同执行文献挖掘、数据分析、ML优化、机器人合成及实验安全监控,显著缩短优化周期。

展望

LLMs正推动网状化学从经验驱动向数据驱动转变,但仍需解决数据质量、模型评估及计算资源消耗等挑战。未来工作可聚焦以下方向:

-

数据集优化:当前数据多分散于不同数据库,需整合失败实验数据,提升模型泛化能力。

-

性能评估标准化:建立针对科学任务的LLM评测体系,量化其在问答、合成条件提取、性质预测等任务上的表现。

-

实验与计算融合:开发高效接口,使LLMs与实验平台无缝衔接,提高自动化实验的可操作性。

-

可持续计算:优化模型规模与能效,减少资源消耗,确保LLMs应用的可持续性。

LLMs作为智能助手,可简化数据挖掘、材料设计及实验优化流程,使更多研究者能够高效参与网状化学研究。随着数据质量和模型能力的不断提升,LLMs将在材料科学的前沿探索中发挥更大作用,推动科学发现进程。

转载请注明:可思数据 » Nat. Rev. Mater. | 大型语言模型驱动的网状化学创新

免责声明:本站来源的信息均由网友自主投稿和发布、编辑整理上传,或转载于第三方平台,对此类作品本站仅提供交流平台,不为其版权负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本站联系,我们将及时更正、删除,谢谢。联系邮箱:elon368@sina.com