这篇文章是系列文章的第二篇,重点关注以人为本的知识来源的重要性,因为法学硕士改变了信息格局。第一篇文章讨论了互联网的变化状态以及由此产生的商业模式的相关转变。

明确地说,我们知道署名对我们的社区和 Stack Overflow 也很重要。除了 Creative Commons 许可或给予作者或知识来源的信用之外,我们知道它还能建立信任。正如我们在之前的帖子中概述的那样,如果没有信任,整个 AI 生态系统都会面临风险。

在 Stack Overflow,归因是不可协商的。作为这一信念和我们对社会责任 AI 的承诺的一部分,Stack Overflow 与OverflowAPI合作伙伴签署的所有合同都必须包含归因要求。所有基于使用公共 Stack 数据的模型的产品都必须将归因提供给影响模型摘要的相关度最高的帖子。API 合作伙伴对社区内容的投资应该用于资助社区及其内容的增长和健康。为此,合作伙伴与我们合作,因为他们希望 Stack Exchange 社区能够接受他们对社区内容的使用,而不仅仅是为了获得许可:他们在开发人员中的声誉很重要,他们明白仅靠 Stack Overflow 数据的归因不足以维护这一声誉。

倾听开发者社区的声音

在我们的2024 年 Stack Overflow 开发者调查中,我们发现 AI 的使用与对其输出的信任之间的差距继续扩大:76% 的受访者正在使用或计划使用 AI 工具,高于 2023 年的 70%,而 AI 的好感度从去年的 77% 下降到 72%。只有 43% 的开发人员表示他们信任 AI 工具的准确性,31% 的开发人员仍然持怀疑态度。这一切的核心是什么?那么,与 AI 开发人员相关的三大道德问题是 AI 传播错误信息的可能性(79%)、数据来源归因缺失或不正确(65%)以及不代表观点多样性的偏见(50%)。

来自技术界和整个社会的压力促使 LLM 开发人员考虑他们对用于生成答案的数据源的影响。这导致了数据采购的紧迫性,这些数据侧重于比公开数据更好的高质量训练数据。数百家公司竞相生产自己的 LLM 模型并将其集成到许多产品中,这推动了高度竞争的环境。由于 LLM 提供商更加关注企业客户,因此需要多层次的数据治理;企业客户对准确性的失误的接受度要低得多(与个人消费者相比),并要求对模型提供的信息和数据安全性负责。

随着人们对人工智能生成内容的信任度不断提高,对作者/主题专家以及创建和策划 LLM 分享内容的更大社区给予认可至关重要。这还可以确保 LLM 使用最相关、最新的信息和内容,最终呈现模型所需的 Rosetta Stone,以建立对来源和由此做出的决策的信任。

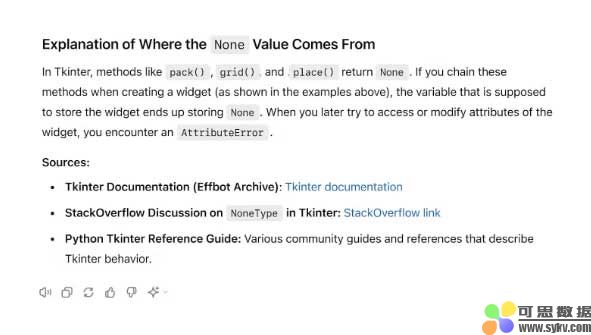

我们所有的 OverflowAPI 合作伙伴都已通过检索增强生成 (RAG) 启用归因。对于那些可能不熟悉它的人来说,检索增强生成是一个 AI 框架,它将生成式大型语言模型 (LLM) 与传统信息检索系统相结合,以实时使用最新知识更新答案(无需重新训练模型)。这是因为生成式 AI 技术功能强大,但受到它们“知道”的内容或“它们所训练的数据”的限制。RAG 通过将信息检索与精心设计的系统提示配对来帮助解决这一问题,这些提示使 LLM 能够从外部来源提供相关、上下文和最新信息。在涉及特定领域知识(如行业首字母缩略词)的情况下,RAG 可以大大提高 LLM 响应的准确性。

LLM 用户可以使用 RAG 从受信任的专有来源生成内容,从而快速且反复地生成最新且相关的文本。例如,可以通过从代码库中输入特定示例来提示您的 LLM 编写高质量的 C# 代码。RAG 还通过将 LLM 的响应建立在用户明确识别的可信事实的基础上来降低风险。

如果您与了解最近事件、了解用户特定信息或对特定主题有更深入了解的聊天机器人进行过交互,那么您很可能在不知不觉中与 RAG 进行过交互。

这项技术正在迅速发展,因此,这提醒我们所有人,我们应该质疑 LLM 在归因方面所能做的事情。最近的发展表明,LLM 回应背后的“思维过程”可能会为归因和来源披露开辟其他途径。随着这些新途径的出现和法律标准的演变,我们将继续为合作伙伴制定归因方法和标准。

归因是什么样的?

鉴于归因的重要性,我们想提供一些使用和公开 Stack Exchange 社区知识的各种产品的示例。我们将继续分享其他公开的示例。

例如,谷歌重点介绍了谷歌 Gemini Cloud Assist 中的知识,该产品目前正在谷歌内部测试,预计将于 2024 年底发布。

随着 Google 扩大与我们的合作伙伴关系,它正在更多地考虑与我们整合的其他切入点:希望在其他 Google 产品、界面和服务中看到 Stack Overflow 内容的归属。

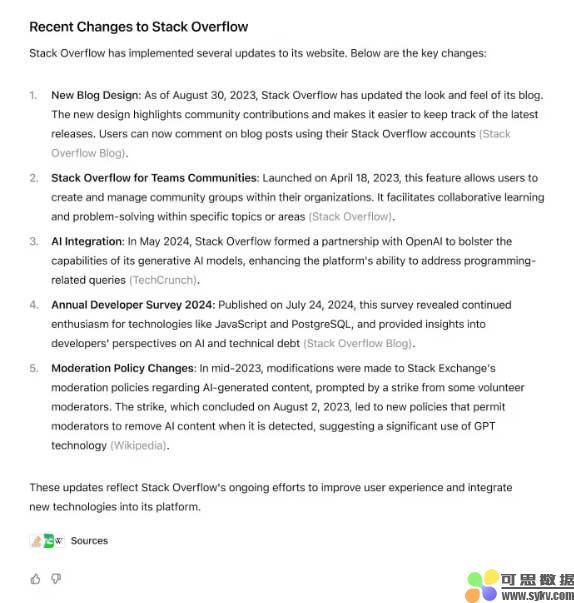

OpenAI 正在 ChatGPT 对话中展示有关各种编码主题的 Stack 结果,帮助推动社区的认可、归因和流量:

OpenAI 的搜索原型 SearchGPT 也在对话响应和搜索结果中显示 Stack 链接,为我们的社区提供了大量链接:

这些集成代表了一个共同的主题:归因内容不仅仅是作者和社区成员的优势。它还代表着更好地为开发人员服务的机会:像这样的代码生成工具,尤其是嵌入了 AI 的代码生成工具,对开发人员具有巨大的潜力和实用性。然而,它们并没有解决所有问题,这给开发人员带来了一个新问题:当您的 LLM 无法充分回答客户的问题时,您会怎么做?Stack Overflow 可以提供帮助。最后,它使 Stack 合作伙伴能够支持遵守 Creative Commons 下的社区许可,这是任何 Stack Exchange 社区内容用户的必需品。

此类链接为开发人员提供了一个切入点,使他们能够更深入地了解 Stack Community 知识世界,将流量带回社区,并使开发人员能够解决 AI 无法解决的复杂问题。创建这些反馈循环可使开发人员、社区和 API 合作伙伴受益于开发和整理社区知识。在未来的几个月和几年里,我们将把这些反馈循环嵌入到我们的产品和服务中,使社区和组织能够利用知识即服务,同时建立对社区内容及其有效性的信任。更重要的是,我们将利用合作伙伴对这些集成的投资直接投资于构建推动社区健康的工具和系统,从而建立对社区的信心。请阅读我们的社区产品战略和路线图系列以获取更多信息,包括本周晚些时候即将发布的社区产品团队的更新。

转载请注明:可思数据 » 归因是开发者信任的基础

免责声明:本站来源的信息均由网友自主投稿和发布、编辑整理上传,或转载于第三方平台,对此类作品本站仅提供交流平台,不为其版权负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本站联系,我们将及时更正、删除,谢谢。联系邮箱:elon368@sina.com