【前沿】机器人:识别AI“盲点”

麻省理工学院和微软研究人员开发的一种新型模型确定了自主系统从训练样本中“学习”的实例,这些实例与现实世界中实际发生的事实不符。工程师可以使用该模型来提高人工智能系统的安全性,例如无人驾驶车辆和自动机器人。

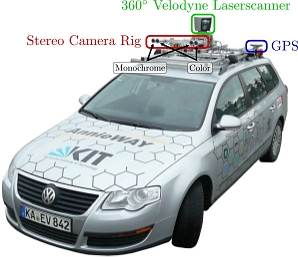

例如,为无人驾驶汽车提供动力的AI系统在虚拟模拟中被广泛训练,以便为几乎所有在路上的事件准备车辆,但有时汽车在现实世界中会出现意外错误。

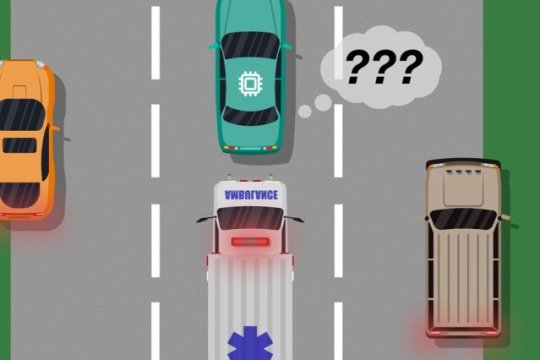

就像一辆未经过培训的无人驾驶汽车,它没有必要的传感器以区分截然不同的场景,例如大型白色轿车和道路上带有红色闪光灯的救护车,如果汽车在高速公路上行驶,救护车在警报器上轻弹,那么汽车可能不会知道减速和停车,因为它并不认为救护车与大型白色轿车不同。

在去年的Autonomous Agents和Multiagent Systems会议以及即将召开的人工智能促进会议上发表的一篇论文中,研究人员描述了一个利用人类输入来揭示这些训练“盲点”的模型。

与传统方法一样,研究人员通过模拟训练设置了AI系统。但是,当人们在现实世界中行动时,人类密切监视系统的行为,在系统制造或即将发生任何错误时提供反馈。然后,研究人员将训练数据与人体反馈数据相结合,并使用机器学习技术生成一个模型,该模型可以精确定位系统最有可能需要更多关于如何正确行动的信息。

研究人员使用视频游戏验证了他们的方法,模拟人员校正了屏幕角色的学习路径。但下一步是将该模型与传统的自动驾驶汽车和机器人培训和测试方法相结合,并提供人工反馈。

“这个模型帮助自治系统更好地了解他们不知道的东西,”第一作者Ramya Ramakrishnan说,他是计算机科学和人工智能实验室的研究生。“很多时候,当部署这些系统时,他们训练有素的模拟与现实世界的设置不符[并且]他们可能会犯错误,例如发生事故。这个想法是利用人来弥合模拟和模拟之间的差距。现实世界,以安全的方式,所以我们可以减少一些错误。“

时间:2019-02-20 18:20 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: