如何让算法解释自己为什么“算法歧视“?

人工智能作为一项新技术,正在改变着人类社会的原有规则和运作方式,人类也逐渐衍生出了害怕被AI支配的恐惧心理,在某种程度上来说,这种恐惧正是源于算法的不透明性。

一、算法的可解释性隐忧

传播学者尼尔·波兹曼在《技术垄断》一书中断言,每一种新技术都既是包袱又是恩赐,不是非此即彼的结果,而是利弊同在的产物。

作为一项新技术,人工智能以其强大的变革势能,重构了人类社会的原有规则和运作方式。人类把选择乃至决策的权力拱手交给AI,在享受着由此产生的便利的同时,却又不自觉地生发出自身及世界将被AI支配的恐惧心理。

这种恐惧表征于各种科幻电影和著作之中,“作为工具的AI反过来统治人类”成为大量影视作品经久不衰的主题;另一方面也渐显于现实社会的诸多反思话语之中,当下对算法偏见、算法歧视以及对算法侵害隐私和社会关系的指责,无一不显现出人类对这项革命性技术的恐惧。

某种程度上,这种恐惧源于算法的不透明性。人类天生会对未知事物感到恐惧,对于人类而言,算法运作宛若“黑箱”——我们负责提供数据、模型和架构,算法负责给出答案,而中间的运作过程却只在暗处进行。这种合作方式看似给我们带来极大便利,但是问题在于,如果算法的运作不可监察、不可解释,将导致人类无法真正理解算法,更不能有效地控制算法,从而也就无法预见和解决算法可能带来的问题。

难以想象,当人类把未来命运寄托于一项既不可知又不可控的技术会诱发怎样的后果。“MIT科技评论”曾发表过一篇题为“人工智能中的黑暗秘密”的文章,指出“没有人真正知道先进的机器学习算法是怎样工作的,而这恐将成为一大隐忧。”而纽约大学AI Now Institute的一份报告甚至建议负责刑事司法、医疗保健、社会福利和教育的公共机构避免使用AI技术。

算法的可解释性隐忧已成为当下多方关注的焦点,也是算法及AI深化发展亟待解决的现实问题。人类渴望理解算法,以期能更好地引导和使用算法。众多互联网公司为解决这一问题进行了大量的工作,但由于种种客观原因的限制,这些努力仍收效甚微。

二、不可解释的算法带来歧视

在上个月的Google I/O 2019开发者大会上,谷歌发布的一项名为“TCAV”的新技术因为与消费者无关因此并没有收到太多关注。但这一项目,似乎为算法可解释性隐忧带来了一种新的解决思路。

桑达尔·皮查伊在此次大会上公布了Google新一阶段的目标:Building a more useful Google for everyone.(“为每个人构建一个更有用的Google”)。但这项目标实现起来颇有难度,因为它意味着谷歌需要着手解决一系列与算法相关的现实问题,比如算法偏见和算法歧视。皮查伊显然也意识到这一点,他指出“偏见”(bias)仍然是机器学习领域一个值得关注的问题,当牵涉到人工智能时,这一问题的风险度则会更高。

许多人认为算法是单纯的技术,并没有什么价值观可言,但实际上算法也像它的人类缔造者一样,存在着各种偏见和歧视。究其本质,算法歧视属于社会结构性歧视的延伸,因为算法的有效性建基于大量数据材料分析,而这些材料大多都源自社会现实,所以究其本质,算法歧视其实是社会结构性歧视的延伸。

比如,训练分类算法进行图像识别,让它能从一堆职业照片中选出“医生”职业。我们首先要为算法提供大量的医生图像进行学习,算法会总结出这些图像的基本特性,比如白色大褂、口罩、听诊器等等,并将其作为标准在识别工作中予以执行,它会把具备同类特征的图像均识别为“医生”。

但问题是由于种种现实和历史原因,在当下医生人群中,男性的比例确实更高。而算法通过上述的学习,并不会理解这是我们当下及未来要努力做出改变的地方,而很可能认定“男性”是“医生”这一职业判定的相关因素,从而在识别中把女性医生筛选出去。

另外的例子是与就业求职相关的算法向男性推荐的工作岗位整体工资要高于向女性推荐的岗位,以及美国警方的犯罪识别系统会认定黑人犯罪概率更高。因此,性别、种族等方面的现实偏见通过算法得以延伸。而算法歧视之所以难以解决,归根结底在于算法的可解释性问题,如果我们不能理解算法的运作方式,自然也就无法得知它为什么会延续歧视,更无法对歧视问题进行解决。

但在算法的黑箱运作机制下,AI做出决策的影响因素并不会显而易见的拉成一个单子摆在研发者的面前。“女性”这一影响因素本身并不会表明为女性,而可能被表述为一系列描述身体视觉特征的像素向量,对于有色人种和其它需要被剔除的影响因素也是同理。这也导致过往的研发人员不可能依靠“看一眼”就将算法中的偏见剔除。

而从现实角度出发,算法偏见也引发了公众对AI的认知偏差,已经是其被污名化的来源之一。种种因素之下,解决算法偏见问题成为目前行业的基本共识。

对于Google来说,这一问题更为迫切。当智能工具为用户执行任务时的功能越来越多时,算法的可解释性和透明度就显得无比重要,因为它等同于用户对谷歌技术更大的信任和更多的商业化使用。皮查伊表示,要为每个人建立一个更有用的谷歌,意味着解决偏见问题,为此谷歌将着力于提高模型的透明度。而这次皮查伊的底气,很大程度上来自于TCAV技术。

三、TCAV,让普通人理解算法的运作方式

TCAV是“概念激活向量测试”(Testing with Concept Activation Vectors)的缩写。由于这项技术主要面向开发人员和数据科学家,而且暂时不开放给第三方使用,所以并不是Google I/O 2019的主角,在相关报道也都被一笔带过。但与其低调的形象不同,TCAV实际上作用极大,并且应用前景极为广阔。

早在开发者大会之前,数据科学家Been Kim团队就发表了一篇Interpretability Beyond Feature Attribution : Quantitative Testing with Concept Activation Vectors (TCAV)的论文,诠释了TCAV的作用原理。总体而言,TCAV是一种算法可解释性的方法,能够直观显示神经网络模型运算所依据的概念及其比重。正因为如此,TCAV也是一种算法歧视纠偏技术,因为它可以被用于观察其他AI模型中的算法歧视倾向。

人类之所以不能理解算法的运作规则,是因为二者“认知方式”存在差异:人类往往使用各种高级概念进行思考和交流,而大多数机器学习模型则关注低阶要素,运用大量抽象概念进行“思考”。比如,人类之所以能判定一张图中的动物是斑马,主要依据它的身形、黑白条纹等高级概念;但算法却不一样,它考量的是不同特征属性(Feature Attribution)的权重。对算法来说,一幅图像中的每个像素都是输入要素,它会关注图片中的每一个像素的显著程度,并赋予它相关的数值,以此作为识别的依据。

问题就在于,人类无法理解算法所采用的识别方式。因为我们在描述事物时,会直接动用颜色、形状等各种高级概念,却永远不会说图像的第6个像素的值是33。因此,即便得到算法运作所生成的各种数值,也无助于我们理解算法的运作过程。

而可解释性的初衷就是使人类更容易理解机器学习模型,特别是对那些缺少技术背景的人更是如此。那么,能不能够让算法的运作方式以人类能看懂的“高级概念”的形式予以呈现?TCAV技术试图解决的正是这个问题。

与典型的可解释性方法不同,TCAV目标是将支撑模型的变量以人类能够理解的高级概念表现出来。它能直观显示在算法运作中各种高级概念的权重,比如颜色、性别、种族、年龄等(即便该概念不是训练的部分)。

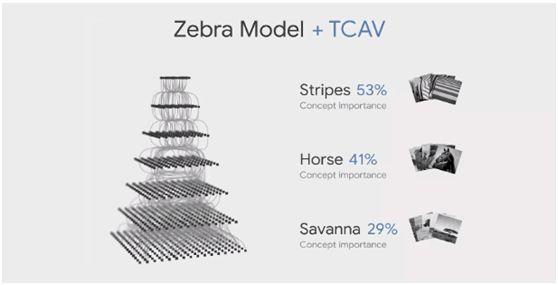

比如,一个训练有素的模型能够检测图像中动物是否是斑马,而TCAV可以帮助我们理解哪些变量在识别图像时发挥了作用,以及各自发挥了多大的重要性,因它对我们理解模型预测原理帮助很大。由结果可见,在各项概念中,“条纹”(Stripes)占据的权重最高,“马的形体”(Horse)次之,“草原背景”(Savanna)的权重最低,但也有29%。

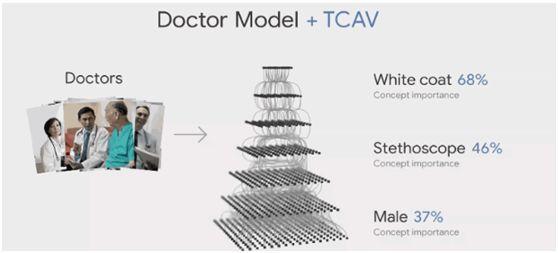

而 TCAV 的这一功能被用于算法纠偏非常合适,当我们把它的这项能力转移到涉及社会现实的识别模型上时,就可以清晰地判定该模型是否涉及歧视。比如,一个用于识别医生图像的算法,由TCAV的结果可见,其高权重的识别概念包括“白色衣服”、“听诊器”以及“男性”等。前两个影响因素是正确的,但关于性别的判断则意味着模型出了偏见需要通过进一步训练进行纠偏。

从更广阔的前景来说,TCAV 可以让普通人也能够轻松理解算法的“思维”,因为它让我们可以理解算法思考过程的每一步。因为 A 得到 B,所以 C,最后得出了 D。而不是像以往的 AI 那样给予 A 的输入便获得 D的结果。这一功能可被应用于其它领域而并非只是用于算法纠偏。

四、结语

TCAV的重要意义在于,它不仅在技术层面以一种极为有效的方式解决了算法的可解释性问题,而且它以人类所使用的高阶语言为呈现形式,即便是没有技术背景的普通人也可窥见算法究竟以何种标准进行运作,是否有所偏倚,进而能够及时解决算法偏见和算法歧视问题。

要知道,算法和AI并非张牙舞爪的妖魔鬼怪,无端的恐惧和忧愁均无助于问题的解决。它更像是正在学步的孩童,需要我们借助于TCAV这样的解释性工具进行对话、达成理解并帮助它更好地成长,这才是引导科技向善的体现。

–END–

时间:2019-06-20 23:34 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: