AI 下一个拐点,图神经网络带来哪些机遇?

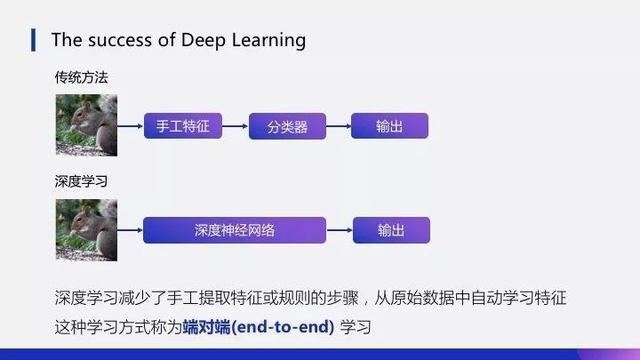

2012 年至今,随着深度神经网络理论与计算设备的发展,卷积神经网络(CNN)得到了快速发展,并被大量应用于计算机视觉、自然语言处理等领域。尤其是在图像分类、目标检测等主要的计算机视觉任务中,CNN 一直都是最主流的方法。

图 1:端到端的学习

卷积神经网络的行与不行

卷积神经网络,虽然取得了巨大成功,但也面临较大局限,即局限于处理欧氏空间的数据(或者有规则的空间数据),比如图像、语音(节点的连接是规则的,能够用一维、二维的矩阵表示,卷积神经网络处理起来很高效)。

图 2:图像、语音的空间数据

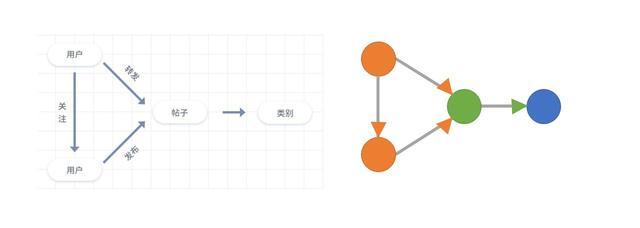

面对无规则的空间数据,如交通流数据、社交多媒体网络数据、化学成分结构数据、生物基因蛋白数据以及知识图谱数据,传统卷积神经网络发挥不了作用(每个节点连接都不尽相同,有的节点有 2 个连接,有的节点 1 个连接)。

图 3:社交网络的图数据结构

规则与无规则的空间数据,本质上说,都可以表示成图结构的形式。那么,有没有一种卷积神经网络既适用于规则的图结构数据,又适用于不规则的数据呢?

挑战深度神经网络的不可解释性

在深度神经网络系统中,分类器和特征模块都是自动学习的,这就导致神经网络有了一个灰色区域:可解释性问题(explain-ability problem)。

在深度神经网络系统中,尽管高度的非线性赋予了多层神经网络极高的模型表示能力,配合一些堪称现代炼丹术的调参技术可以在很多问题上达到非常喜人的表现,大家如果经常关注 AI 的头条新闻,那些深度神经网络带来的不可思议的最新突破甚至经常会让人产生 AI 马上要取代人类的恐惧和幻觉。

但正如贝叶斯网络的创始人 Pearl 所指出的,「几乎所有的深度学习突破性的本质上来说都只是些曲线拟合罢了」,他认为今天人工智能领域的技术水平只不过是上一代机器已有功能的增强版。虽然我们造出了准确度极高的机器,但最后只能得到一堆看上去毫无意义的模型参数和拟合度非常高的判定结果,但实际上模型本身也意味着知识,我们希望知道模型究竟从数据中学到了哪些知识(以人类可以理解的方式表达的)从而产生了最终的决策。

举个例子,我想基于深度神经网络模型开发一个帮助医生判定病人风险的应用,除了最终的判定结果之外,我可能还需要了解模型产生这样的判定是基于病人哪些因素的考虑。如果一个模型完全不可解释,那么在很多领域的应用就会因为没办法给出更多可靠的信息而受到限制。这也是为什么在深度学习准确率这么高的情况下,仍然有一大部分人倾向于应用可解释性高的传统统计学模型的原因。

人工智能 2.0

深度神经网络在非欧氏空间数据上的局限,以及不可解释性,近年来,逐渐与图神经网络联系起来。图神经网络(GNN)是指将深度神经网络应用于图结构数据上,陆续应用于非欧氏空间数据领域,并取得不错效果,已成为火热的研究方向。除了在非欧氏空间数据的表现,图卷积神经网络(GCN)在图像分类、目标检测、语义分割、视觉问答等领域的应用,已被陆续发表在 CVPR、ICCV、ECCV、NeurIPS 等计算机视觉与神经网络的顶级会议中。

鉴于此,GNN 被誉为人工智能 2.0,解决基于深度神经网络为代表的人工智能 1.0 不能进行的推理或者可解释性的挑战。

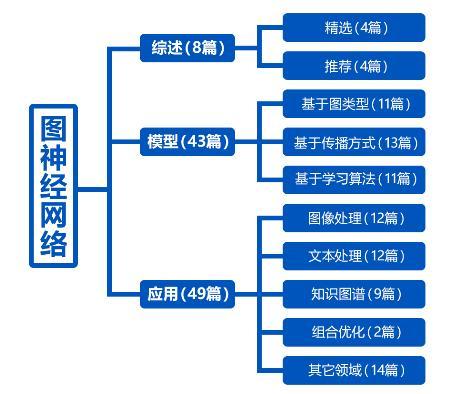

现整理了 100 篇图神经网络 GNN 领域的顶会论文,并按照综述、模型、应用进行分类。

图 4:百篇 GNN 论文集

时间:2019-03-29 18:43 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: