「回顾」机器学习与推荐系统实践

分享嘉宾:刘志强奇虎 360 推荐算法架构师

编辑整理:周峰

内容来源:DataFun AI Talk《机器学习与推荐系统实践》

出品社区:DataFun

注:欢迎转载,转载请注明出处。

1. 摘要

本次分享内容为机器学习在推荐系统的应用。主要介绍推荐系统实践中遇到基本问题,以及基于机器学习技术的解决方案。过程中涉及到“概率图模型、神经网络等”等方法在解决“用户冷启、精准兴趣与个性化、资源协同”等问题中的取舍。最后指出如何对实际的推荐系统进行有效的评估等问题。

2. 推荐系统

2.1 推荐系统介绍

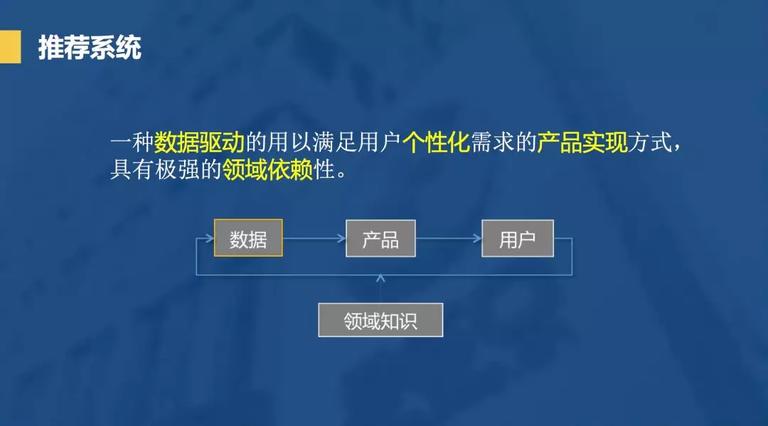

推荐系统不仅仅是推荐算法,我们应当将其看成一个产品。或者说它是一种数据驱动的用以满足用户个性化需求的产品实现方式,有极强的领域依赖性。好的推荐系统要了解用户,理解用户, 尊重用户。

2.2 推荐系统问题

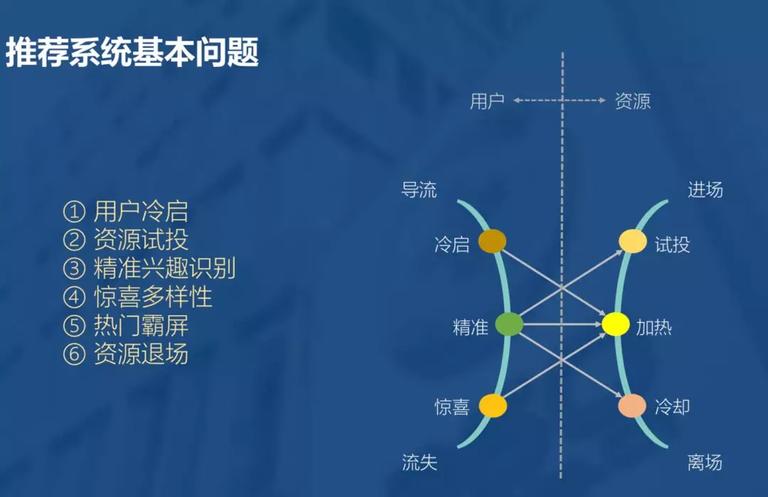

推荐系统本质是将人和物品关联起来,而系统对用户的理解也是由浅入深,初来时彼此陌生,需要有一个冷启的过程,逐渐把握用户的喜好。随着用户行为的丰富,系统对用户兴趣的描述也越来越客观,此时便可能得到更准确的用户偏好,进而完成更精准的推荐。然而物极必反,用户对于一个平台的认知与期望也是一样。随着用户的深度使用,势必对推荐系统生出更高的期待和要求。这时,便可能需要系统在满足深度用户某种刁钻的口味,与大众用户的普遍期待中做出某种取舍。用户也就不可避免的出现了流失。因为系统的能力终归有限,而用户的期望无限。

此外资源也会经历类似的过程,新进场的资源虽然天然有某种内容的属性,但其被用户接受,仍然不可避免需要经历一个过程。过程中有些资源会被淘汰,有些则会成长为热门。在不断地引入新资源的过程中,再热门的资源都会有过期的一天。就好比,再会保养的人,也逃不过岁月的流逝。甚至,为了保持系统的实时性,热门的资源需要主动地让出在系统中的曝光份额。

在推荐系统的优化过程中,用户的取舍与资源的冷热,都是需要仔细设计以服务于系统的整体目标。

3. 算法实践

3.1 用户冷启动

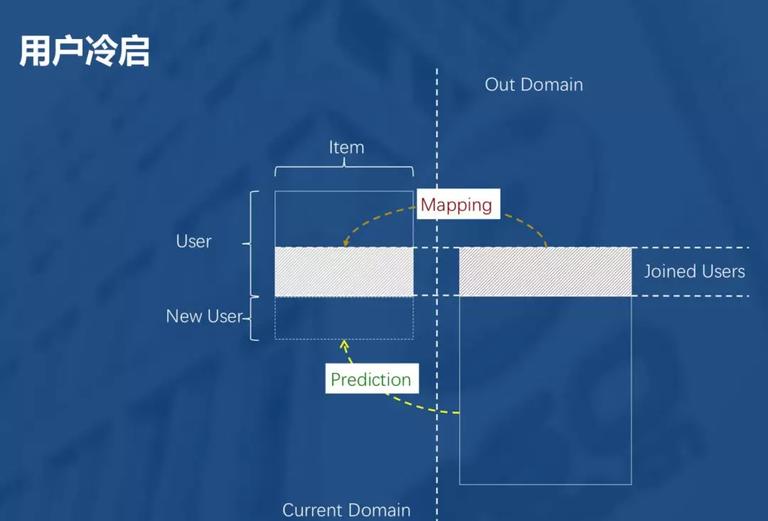

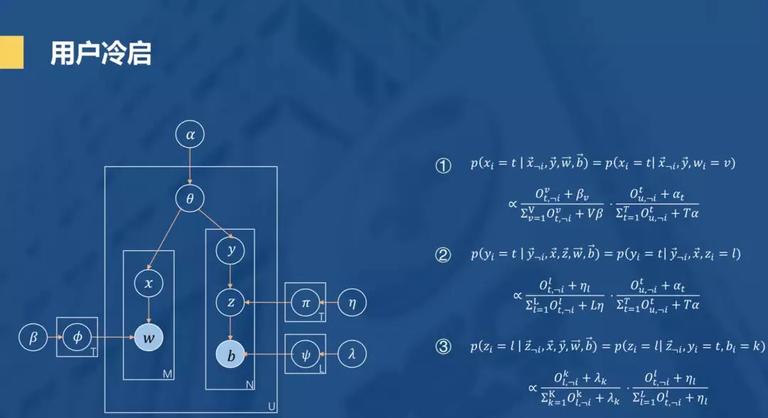

如图,将用户和物品抽象成一个 User-Item 的矩阵,表达用户 users 对物品 items 的喜好程度。用户冷启动要解决的是当来了新的用户 new users,如何得到新用户对物品 items 的喜好程度。一个常见的解决办法是能不能从其他维度或领域的数据来判断新用户对现存物品的喜好。具体解释就是某个用户可能在已有领域 current domain 和另一领域 out domain 都有相关行为,可对两个不同领域的行为建立一个 mapping,当新用户来的时候,如果在另一领域有相关行为,可用该 mapping 作出 prediction,得到新用户对 item 的喜好程度。

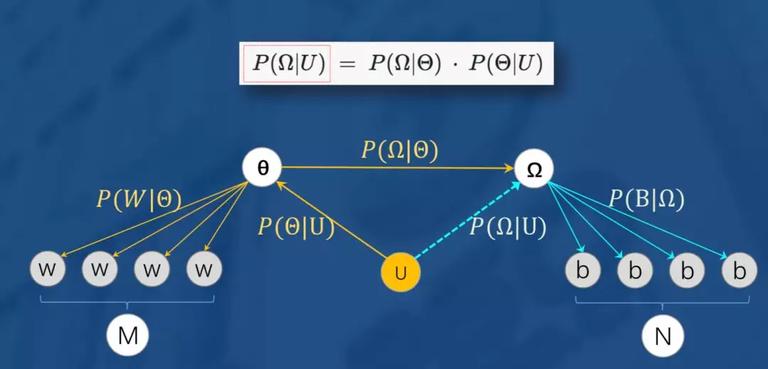

数学上对 mapping 进行建模如上图,用户 U 喜欢的 M 个 W 依托于用户兴趣分布,只要得到映射,这样便可以通过公式间接得到, 我们再将这个模型抽象成如下概率图模型。

可以发现,如果只看左边这就是就是一个 LDA 主题模型。先对 LDA 主题模型做个简单介绍,是每篇文档的主题分布的共轭先验分布(dirichlet)超参数,表示文档的主题分布,x 就是文档当前词被赋予的主题,是一个隐变量,是每个主题的词分布的先验分布(dirichlet)超参,就是主题的词分布,它与决定词主题的 X 共同决定产生的当前词 W 在我们的推荐场景中的概率,我们可以把每个 user 看作一篇文档 document,文档的主题也就是 user 的喜好,概率图中词 w 就是具体的 item。

接下来我们再来看右边, Z 为增加的隐变量,通过映射π,即可在的喜好分布中得到另一个领域的喜好分布, 最后生成在另一领域的喜好物品 b。模型的迭代用图中右边的三个公式得到。

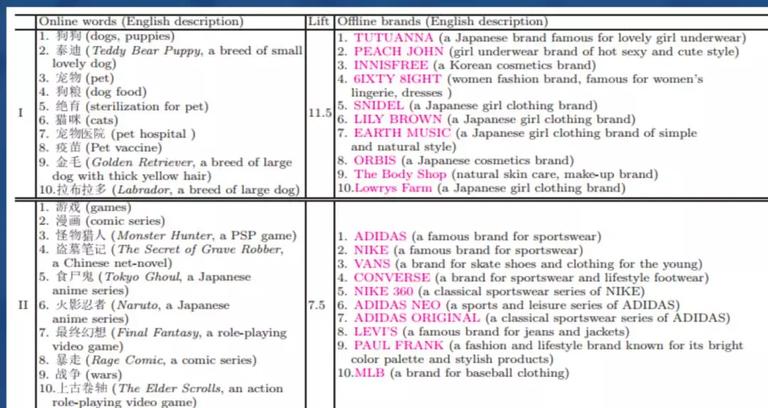

具体举个实际的例子,根据新用户的搜索行为 (out domain) 对超市购物行为 (current domain) 做推荐,即通过建立从搜索的关键词到超市购买商品的映射关系,对新用户进行商品的推荐。如下图,搜索狗狗,泰迪等的用户,会对其推荐化妆品,女性服装等,比较符合逻辑。

3.2 精准兴趣

在推荐系统中,我们往往使用用户的点击行为来估计用户的喜好类型。然而用户的每次点击未必都是经过其深思熟虑之后的结果,因此行为本身会存在一个置信度的问题。而这个置信度是未知的。那我们如何建立模型表达用户的精准兴趣呢?

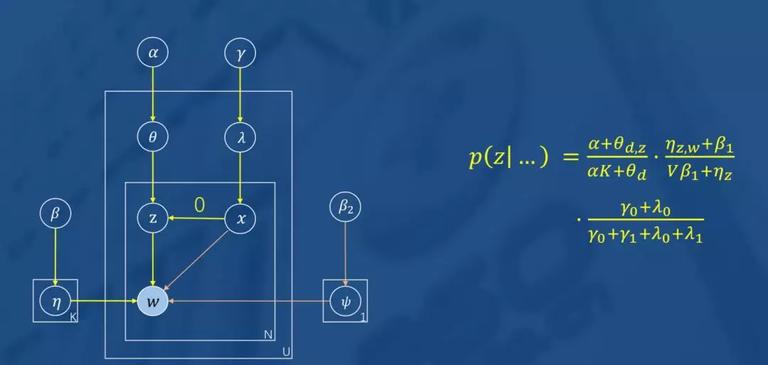

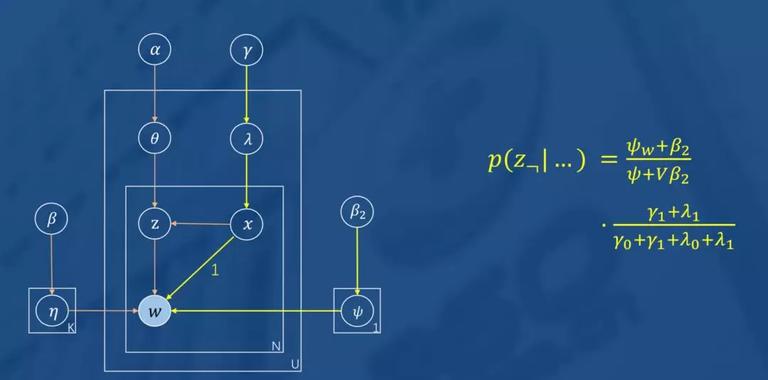

我们将用户点击的行为抽象为两种可能,一种是喜欢 (深思熟虑置信度较高) , 另一种为随意 (偶然为之,置信度较低,或可理解为系统的 bias)。我们建立如下图模型来模拟用户两种行为:

如图所示,图模型左边就是一个 LDA,右边的是一个二项分布,表示用户因为喜欢或者不是因为喜欢而产生点击行为的概率, 是的共轭先验分布(Beta 分布)超参。

当分布产生的 x 为 0 时,表示用户因喜欢而点击(如上图),这时将完全按照 LDA 主题模型生成用户 U 喜欢的物品 w;当分布产生的 x 为 1 时,表示用户对 w 的点击不是因为喜欢。迭代公式如图所示,不再赘述。

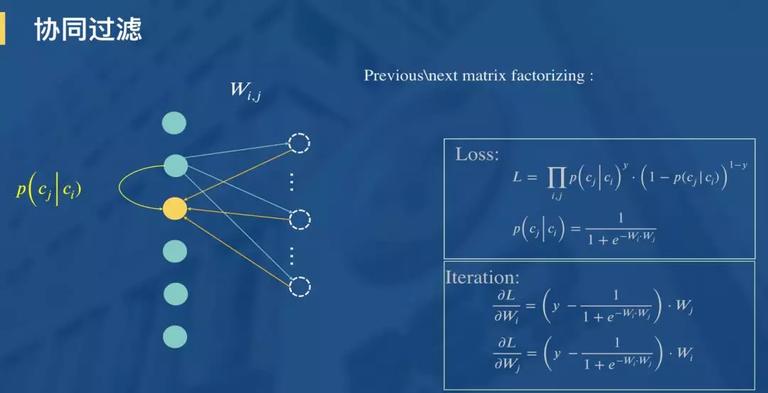

3.3 协同过滤

讲到推荐系统,一定少不了相似推荐或协同过滤。接下来我们就介绍一种根据用户点击行为序列(把不是用户因为喜欢的点击可以去掉)来构建资源之间的推荐转移关系,进而实现物品协同推荐的方案。如图所示:

我们通过拟合用户相邻点击之间“点了还点”的似然,来为每个 Item 计算得到一个向量表达。你可以将其理解为最简单版本的序列模型,也可以将其看成一个 0,1 矩阵的分解,也可以将其看成一个只有一个输入特征、激活函数为 y=x,且共享输入层与输出层权值的神经网络。如图中所示,使用二项分布来描述对目标物品的点击概率,对权重,分别求偏导数得到权重更新的梯度,使用梯度迭代即可求解。

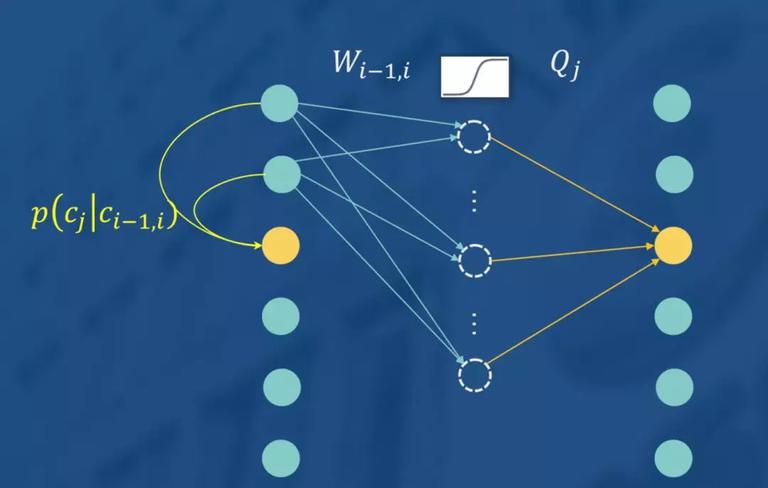

如果你觉得这个网络使用同一个 W 限制模型的表达能力,或者隐层不做 nonlinear 显得不够专业,则完全可以将模型变为如下形式。

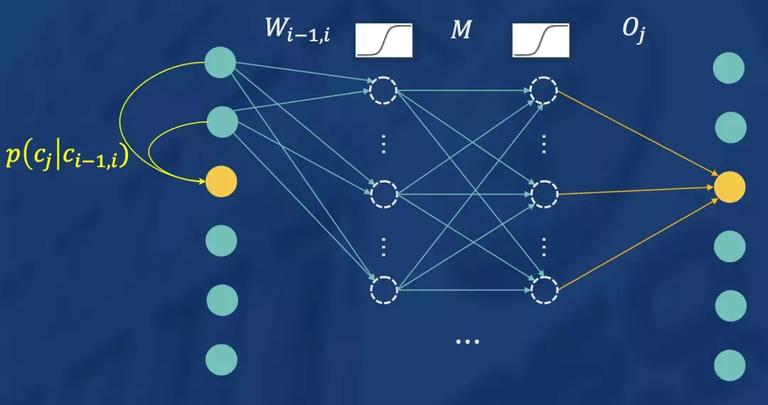

在或者,觉得不够深,则可以将模型变为如下形式:

实际中,很多事情并不是“越深越好”,需要根据业务的需要做取舍。

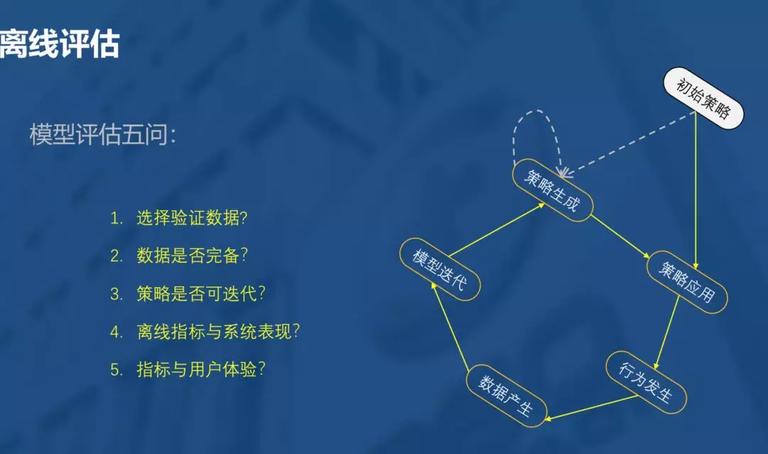

4. 评估

4.1 离线评估

关于离线评估,这里不太想介绍具体指标和方法。更多的是我们在做推荐系统评估过程中的一些问题和思考。以及我们在做评估时需要注意的点:

1. 评估数据的选择?

是不是模型在评估数据上的表现越好,就能够代表,推荐策略或算法的表现越好?评估数据是怎么产生的,是否与系统的未来目标一致?评估数据是否存在 bias?

2. 训练数据的完备性?

你用来训练模型的数据是否客观、准确、全面?分布是否合理?

3. 策略可迭代性?

准确性越高的算法,可能对系统的伤害也会越大!策略是否未系统的未来留了足够的空间?会不会发生“竭泽而渔”的惨剧?

总之,初始策略的应用会限定用户的行为发生,决定了产生了什么类型的数据,进而决定了生成的模型描述的内容。而新的策略的应用又决定了下一次策略迭代所使用的数据生成过程。我们做机器学习都会追求模型的收敛。而某一次收敛性很好(过拟合)的策略,都可能导致系统未来不再具备继续迭代的可能性。而这种过拟合恰恰是我们所认为的策略泛化能力(对未来测试集数据的友好性)。

4.2 在线评估

主要是注意召回和 Ranking 的关系。

举个例子,假设现有推荐列表平均 CTR 是 7%,召回方案一结果平均是 10%,方案二平均是 3%,通常来说 10% 的方案更好,如果方案一结果增加到推荐列表中,则原先推荐列表中必有一部分资源被挤掉,如果被挤掉部分的 CTR 大于 10%(注意 7% 是平均值),则最终的 CTR 必然下降。换言之,将 3% 的方案增加到推荐结果中,如果被替换的部分之前 CTR 为 1%,则推荐效果会有所提升。因此,召回策略推荐效果的好坏并不完全取决于是否召回了用户点击率更高的资源,还取决与将其放在什么位置。

召回与 ranking 需要在系统当前能力范围内做匹配,一方超前或者落后,对系统来讲可能都是有害的。

时间:2019-01-03 00:28 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

- [机器学习]堪比当年的LSTM,Transformer引燃机器学习圈:它是

- [机器学习]论机器学习领域的内卷:不读PhD,我配不配找工

- [机器学习]Attention!当推荐系统遇见注意力机制

- [机器学习]机器学习基础图表:概念、原理、历史、趋势和算法

- [机器学习]分析了 600 多种烘焙配方,机器学习开发出新品

- [机器学习]2021年的机器学习生命周期

- [机器学习]物联网和机器学习促进企业业务发展的5种方式

- [机器学习]机器学习中分类任务的常用评估指标和Python代码实现

- [机器学习]机器学习和深度学习的区别是什么?

- [机器学习]堪比当年的LSTM,Transformer引燃机器学习圈:它是

相关推荐:

网友评论: