万物皆 Embedding,从经典的 word2vec 到深度学习基本

这里是 王喆的机器学习笔记 的第四篇文章,之前我们一起讨论了阿里的 DIN,YouTube 的深度学习推荐系统,本来今天想再分享另一篇科技巨头的业界前沿文章,Airbnb 的 Embedding 方法 但因为文章中涉及 word2vec 的技术细节,为了保证一些初学者的知识是自洽的,我还是想在此之前详细介绍一下深度学习的基本操作 Embedding 以及从 word2vec 到 item2vec 的模型原理。

什么是 embedding?为什么说 embedding 是深度学习的基本操作?

简单来说,embedding 就是用一个低维的向量表示一个物体,可以是一个词,或是一个商品,或是一个电影等等。这个 embedding 向量的性质是能使距离相近的向量对应的物体有相近的含义,比如 Embedding(复仇者联盟) 和 Embedding(钢铁侠) 之间的距离就会很接近,但 Embedding(复仇者联盟) 和 Embedding(乱世佳人) 的距离就会远一些。

除此之外 Embedding 甚至还具有数学运算的关系,比如 Embedding(马德里)-Embedding(西班牙)+Embedding(法国)≈Embedding(巴黎)

从另外一个空间表达物体,甚至揭示了物体间的潜在关系,上次体会这样神奇的操作还是在学习傅里叶变换的时候,从某种意义上来说,Embedding 方法甚至具备了一些本体论的哲学意义。

言归正传,Embedding 能够用低维向量对物体进行编码还能保留其含义的特点非常适合深度学习。在传统机器学习模型构建过程中,我们经常使用 one hot encoding 对离散特征,特别是 id 类特征进行编码,但由于 one hot encoding 的维度等于物体的总数,比如阿里的商品 one hot encoding 的维度就至少是千万量级的。这样的编码方式对于商品来说是极端稀疏的,甚至用 multi hot encoding 对用户浏览历史的编码也会是一个非常稀疏的向量。而深度学习的特点以及工程方面的原因使其不利于稀疏特征向量的处理(这里希望大家讨论一下为什么?)。因此如果能把物体编码为一个低维稠密向量再喂给 DNN,自然是一个高效的基本操作。

使 embedding 空前流行的 word2vec

对 word 的 vector 表达的研究早已有之,但让 embedding 方法空前流行,我们还是要归功于 google 的 word2vec。我们简单讲一下 word2vec 的原理,这对我们之后理解 AirBnB 对 loss function 的改进至关重要。

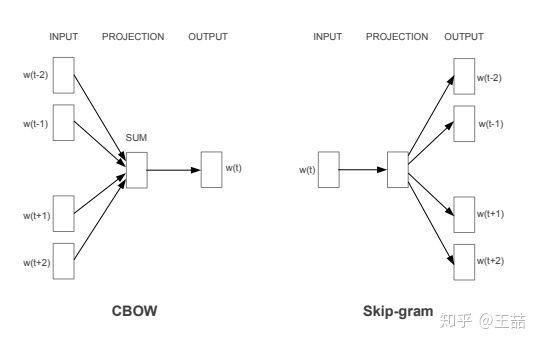

既然我们要训练一个对 word 的语义表达,那么训练样本显然是一个句子的集合。假设其中一个长度为 T 的句子为 。这时我们假定每个词都跟其相邻的词的关系最密切,换句话说每个词都是由相邻的词决定的(CBOW 模型的动机),或者每个词都决定了相邻的词(Skip-gram 模型的动机)。如下图,CBOW 的输入是

。这时我们假定每个词都跟其相邻的词的关系最密切,换句话说每个词都是由相邻的词决定的(CBOW 模型的动机),或者每个词都决定了相邻的词(Skip-gram 模型的动机)。如下图,CBOW 的输入是  周边的词,预测的输出是

周边的词,预测的输出是  ,而 Skip-gram 则反之,经验上讲 Skip-gram 的效果好一点,所以本文从 Skip-gram 模型出发讲解模型细节。

,而 Skip-gram 则反之,经验上讲 Skip-gram 的效果好一点,所以本文从 Skip-gram 模型出发讲解模型细节。

word2vec 的两种模型结构 CBOW 和 Skip-gram

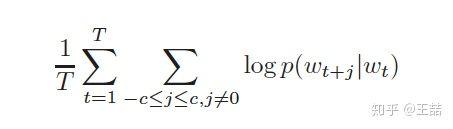

那么为了产生模型的正样本,我们选一个长度为 2c+1(目标词前后各选 c 个词)的滑动窗口,从句子左边滑倒右边,每滑一次,窗口中的词就形成了我们的一个正样本。

有了训练样本之后我们就可以着手定义优化目标了,既然每个词  都决定了相邻词

都决定了相邻词  ,基于极大似然,我们希望所有样本的条件概率

,基于极大似然,我们希望所有样本的条件概率  之积最大,这里我们使用 log probability。我们的目标函数有了:

之积最大,这里我们使用 log probability。我们的目标函数有了:

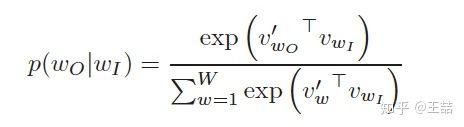

接下来的问题是怎么定义  ,作为一个多分类问题,最简单最直接的方法当然是直接用 softmax 函数,我们又希望用向量

,作为一个多分类问题,最简单最直接的方法当然是直接用 softmax 函数,我们又希望用向量  表示每个词 w,用词之间的距离

表示每个词 w,用词之间的距离  表示语义的接近程度,那么我们的条件概率的定义就可以很直观的写出。

表示语义的接近程度,那么我们的条件概率的定义就可以很直观的写出。

看到上面的条件概率公式,很多同学可能会习惯性的忽略一个事实,就是

我们用  去预测

去预测  ,但其实这二者的向量表达并不在一个向量空间内。

,但其实这二者的向量表达并不在一个向量空间内。

就像上面的条件概率公式写的一样,  和

和  分别是词 w 的输出向量表达和输入向量表达。** 那什么是输入向量表达和输出向量表达呢?** 我们画一个 word2vec 的神经网络架构图就明白了。

分别是词 w 的输出向量表达和输入向量表达。** 那什么是输入向量表达和输出向量表达呢?** 我们画一个 word2vec 的神经网络架构图就明白了。

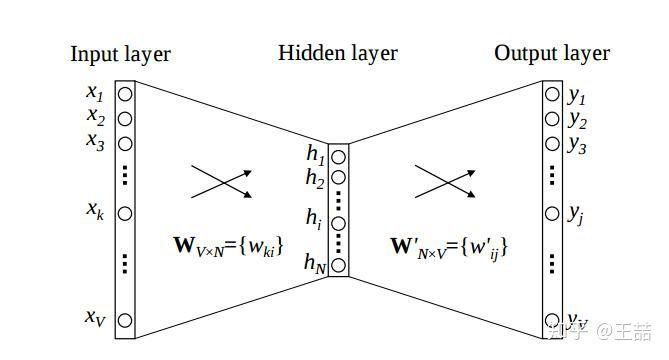

word2vec 的算法架构

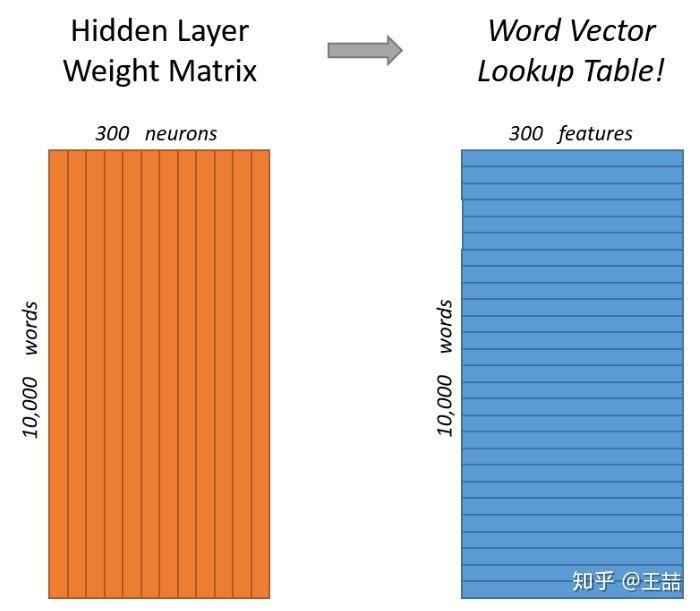

根据  的定义,我们可以把两个 vector 的乘积再套上一个 softmax 的形式转换成上面的神经网络架构。在训练过程中我们就可以通过梯度下降的方式求解模型参数了。那么上文所说的输入向量表达就是 input layer 到 hidden layer 的权重矩阵

的定义,我们可以把两个 vector 的乘积再套上一个 softmax 的形式转换成上面的神经网络架构。在训练过程中我们就可以通过梯度下降的方式求解模型参数了。那么上文所说的输入向量表达就是 input layer 到 hidden layer 的权重矩阵  ,而输出向量表达就是 hidden layer 到 output layer 的权重矩阵

,而输出向量表达就是 hidden layer 到 output layer 的权重矩阵  。

。

那么到底什么是我们通常意义上所说的词向量  呢?

呢?

其实就是我们上面所说的输入向量矩阵  中每一行对应的权重向量。于是这个权重矩阵自然转换成了 word2vec 的 lookup table。

中每一行对应的权重向量。于是这个权重矩阵自然转换成了 word2vec 的 lookup table。

那么问题也来了,我们能把输出矩阵  的列向量当作 word 的 vector 表达吗?大家可以讨论一下。

的列向量当作 word 的 vector 表达吗?大家可以讨论一下。

当然在训练 word2vec 的过程中还有很多工程技巧,比如用 negative sampling 或 Hierarchical Softmax 减少词汇空间过大带来的计算量,对高频词汇进行降采样避免对于这些低信息词汇的无谓计算等。我们在之前的专栏文章中有过讨论,在具体实现的时候最好参考 Google 的原文 Distributed Representations of Words and Phrases and their Compositionality

从 word2vec 到 item2vec

在 word2vec 诞生之后,embedding 的思想迅速从 NLP 领域扩散到几乎所有机器学习的领域,我们既然可以对一个序列中的词进行 embedding,那自然可以对用户购买序列中的一个商品,用户观看序列中的一个电影进行 embedding。而广告、推荐、搜索等领域用户数据的稀疏性几乎必然要求在构建 DNN 之前对 user 和 item 进行 embedding 后才能进行有效的训练。

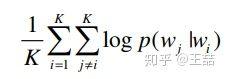

具体来讲,如果 item 存在于一个序列中,item2vec 的方法与 word2vec 没有任何区别。而如果我们摒弃序列中 item 的空间关系,在原来的目标函数基础上,自然是不存在时间窗口的概念了,取而代之的是 item set 中两两之间的条件概率。

item2vec 目标函数:大小为 K 的 item set 中两两 item 的 log probability 之和

具体可以参考 item2vec 的原文 Item2Vec:Neural Item Embedding for Collaborative Filtering

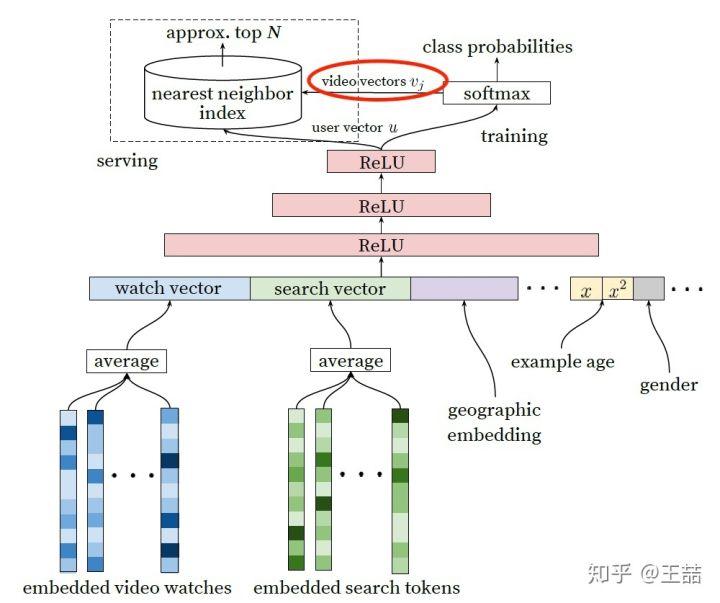

但 embedding 的应用又远不止于此,事实上,由于我们也可以把输出矩阵的列向量当作 item embedding,这大大解放了我们可以用复杂网络生成 embedding 的能力。读过我专栏上一篇文章 YouTube 深度学习推荐系统的十大工程问题 的同学肯定知道,YouTube 在 serve 其 candidate generation model 的时候,只将最后 softmax 层的输出矩阵的列向量当作 item embedding vector,而将 softmax 之前一层的值当作 user embedding vector。在线上 serving 时不用部署整个模型,而是只存储 user vector 和 item vector,再用最近邻索引进行快速搜索,这无疑是非常实用的 embedding 工程经验,也证明了我们可以用复杂网络生成 user 和 item 的 embedding。

YouTube 的 user 和 video embedding 网络

KDD 2018 best paper Real-time Personalization using Embeddings for Search Ranking at Airbnb 也介绍了 Airbnb 的 embedding 最佳实践,下周我们再详细介绍 Airbnb 如何将业务场景与 embedding 方法结合起来。

又到了收获最大的问题讨论的环节了,希望所有人都能各抒己见,互通有无,相信之前专栏的讨论已经让所有读者获益。

- 为什么说深度学习的特点不适合处理特征过于稀疏的样本?

- 我们能把输出矩阵中的权重向量当作词向量吗?

- 为什么在计算 word similarity 的时候,我们要用 cosine distance,我们能够用其他距离吗?

-

在 word2vec 的目标函数中,两个词

的词向量

的词向量  其实分别来自输入权重矩阵和输出权重矩阵,那么在实际使用时,我们需要分别存储输入矩阵和输出矩阵吗?还是直接用输入矩阵当作 word2vec 计算 similarity 就好了?

其实分别来自输入权重矩阵和输出权重矩阵,那么在实际使用时,我们需要分别存储输入矩阵和输出矩阵吗?还是直接用输入矩阵当作 word2vec 计算 similarity 就好了?

这里是 王喆的机器学习笔记 的第四篇文章,水平有限,欢迎大家吐槽,批评,纠错。

参考资料:

- Recommender System Paper List

- Real-time Personalization using Embeddings for Search Ranking at Airbnb

- Item2Vec:Neural Item Embedding for Collaborative Filtering

- Distributed Representations of Words and Phrases and their Compositionality

- YouTube 深度学习推荐系统的十大工程问题

- 重读 Youtube 深度学习推荐系统论文,字字珠玑,惊为神文

时间:2018-12-28 22:53 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: