Apache Spark 2.4 正式发布,重要功能详细介绍

美国时间 2018年11月08日 正式发布了。一如既往,为了继续实现 Spark 更快,更轻松,更智能的目标,Spark 2.4 带来了许多新功能,如下:

♦ 添加一种支持屏障模式(barrier mode)的调度器,以便与基于MPI的程序更好地集成,例如, 分布式深度学习框架;

♦ 引入了许多内置的高阶函数,以便更容易处理复杂的数据类型(比如数组和 map);

♦ 开始支持 Scala 2.12;

♦ 允许我们对 notebooks 中的 DataFrame 进行热切求值(eager evaluation),以便于调试和排除故障;

♦ 引入新的内置 Avro 数据源。

除了这些新功能外,该版本还重点关注可用性,稳定性和优化,解决了超过1000 个tickets。 Spark 贡献者的其他显着特征包括:

♦ 消除 2GB 块大小的限制 [SPARK-24296, SPARK-24307]

♦ 提升 Pandas UDF [SPARK-22274, SPARK-22239, SPARK-24624]

♦ 图片模式数据源(Image schema data source )[SPARK-22666]

♦ Spark SQL 加强[SPARK-23803, SPARK-4502, SPARK-24035, SPARK-24596, SPARK-19355]

♦ 内置文件源改进 [SPARK-23456, SPARK-24576, SPARK-25419, SPARK-23972, SPARK-19018, SPARK-24244]

♦ Kubernetes 整合加强 [SPARK-23984, SPARK-23146]

在这篇文章中,我们简要总结了一些更高级别的功能和改进。

Barrier Execution Mode

Barrier Execution Mode 是 Project Hydrogen 的一部分,这是 Apache Spark 的一项计划,旨在将最先进的大数据和 AI 技术结合在一起。它可以将来自 AI 框架的分布式训练作业正确地嵌入到 Spark 作业中。我们通常会像 All-Reduce 这样来探讨复杂通信模式(complex communication patterns),因此所有的任务都需要同时运行。这不符合 Spark 当前使用的 MapReduce 模式 。使用这种新的执行模式,Spark 同时启动所有训练任务(例如,MPI 任务),并在任务失败时重新启动所有任务。Spark 还为屏障(barrier tasks)任务引入了一种新的容错机制。当任何障碍任务在中间失败时,Spark 将中止所有任务并重新启动当前 stage。

内置高阶函数

在 Spark 2.4 之前,为了直接操作复杂类型(例如数组类型),有两种典型的解决方案:

♦ 将嵌套结构展开为多行,并应用某些函数,然后再次创建结构;

♦ 编写用户自定义函数(UDF)。

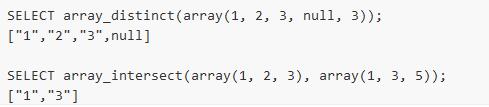

新的内置函数可以直接操作复杂类型,高阶函数可以使用匿名 lambda 函数直接操作复杂值,类似于UDF,但具有更好的性能。比如以下两个高阶函数:

内置 Avro 数据源

Apache Avro 是一种流行的数据序列化格式。它广泛用于 Apache Spark 和 Apache Hadoop 生态系统,尤其适用于基于 Kafka 的数据管道。从 Apache Spark 2.4 版本开始,Spark 为读取和写入 Avro 数据提供内置支持。新的内置 spark-avro 模块最初来自 Databricks 的开源项目Avro Data Source for Apache Spark。除此之外,它还提供以下功能:

♦ 新函数 from_avro() 和 to_avro() 用于在 DataFrame 中读取和写入 Avro 数据,而不仅仅是文件。

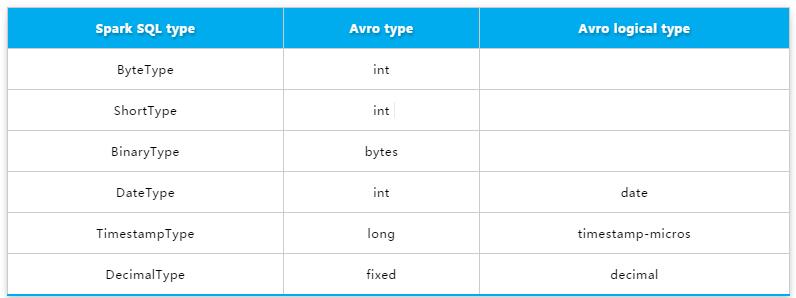

♦ 支持 Avro 逻辑类型(logical types),包括 Decimal,Timestamp 和 Date类型。Spark SQL 和 Avro 的数据类型之间的转换可以参见下面:

2

2

♦ 倍读取吞吐量提高和10%写入吞吐量提升。

支持 Scala 2.12

从 Spark 2.4 开始,Spark 支持 Scala 2.12,并分别与 Scala 2.11 和 2.12 进行交叉构建,这两个版本都可以在 Maven 存储库和下载页面中使用。现在,用户可以使用 Scala 2.12 来编写 Spark 应用程序。

Scala 2.12 为 Java 8 带来了更好的互操作性,Java 8 提供了改进的 lambda 函数序列化。 它还包括用户期望的新功能和错误修复。

Pandas UDF 提升

Pandas UDF 是从 Spark 2.3 开始引入的。在此版本中,社区收集了用户的反馈,并不断改进 Pandas UDF。

除了错误修复之外,Spark 2.4 中还有2个新功能:

♦ SPARK-22239 使用 Pandas UDF 来用户自定义窗口函数。

♦ SPARK-22274 使用 Pandas UDF 来用户自定义聚合函数。

我们相信这些新功能将进一步改善 Pandas UDF 的使用,我们将在下一版本中不断改进Pandas UDF。

Image Data Source

社区从图像/视频/音频处理行业看到了更多案例。为这些提供 Spark 内置数据源简化了用户将数据导入 ML 训练的工作。在 Spark 2.3 版本中,图像数据源是通过ImageSchema.readImages 实现的。Spark 2.4 发行版中的 SPARK-22666 引入了一个新的 Spark 数据源,它可以作为 DataFrame 从目录中递归加载图像文件。现在加载图像非常简单:

df = spark.read.format("image").load("...")

Kubernetes 整合增强

Spark 2.4 包含许多 Kubernetes 集成的增强功能。主要包括这三点:

♦ 首先,此版本支持在 Kubernetes 上运行容器化 PySpark 和 SparkR 应用程序。Spark 为 Dockerfiles 提供了 Python 和 R 绑定,供用户构建基本映像或自定义它以构建自定义映像。

♦ 其次,提供了客户端模式。用户可以在 Kubernetes 集群中运行的 pod 里面运行交互式工具(例如,shell或 notebooks)。

♦ 最后,支持挂载以下类型的 Kubernetes volumes :emptyDir,hostPath 和 persistentVolumeClaim。

灵活的 Streaming Sink

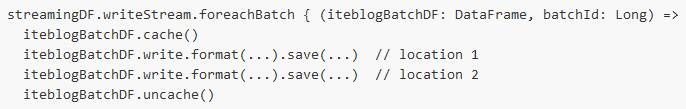

许多外部存储系统已经有批量连接器(batch connectors),但并非所有外部存储系统都有流式接收器(streaming sinks)。在此版本中,即使存储系统不支持将流式传输作为接收器(streaming as a sink)。streamingDF.writeStream.foreachBatch(...) 允许我们在每个微批次(microbatch)的输出中使用 batch data writers。例如,过往记忆告诉你可以使用 foreachBatch 中现有的 Apache Cassandra 连接器直接将流式查询的输出写入到 Cassandra。具体如下:

同样,你也可以使用它将每个微批输出(micro-batch output)应用于 streaming DataFrames 中,许多 DataFrame/Dataset 操作在 streaming DataFrames 是不支持的,具体使用如下:

时间:2018-11-15 23:12 来源: 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: