相关不等于因果,深度学习让AI问出“十万个为什么”

大数据文摘出品

来源:searchenterpriseai

编译:张大笔茹

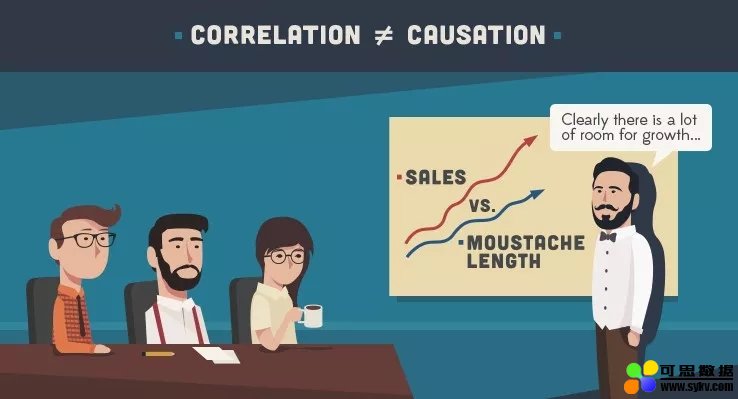

生活经验告诉我们,相关关系并不能直接推导出因果关系,但不管是日常生活还是学术研究,对于因果关系的解释要远比相关关系重要得多。很多时候,我们也会对事件之间的因果关系捉襟见肘。

如果,把这个过程交给AI来处理会怎样呢?

AI可以利用深度学习技术来构建相关关系模型。但是,用于确定事情发生原因的因果深度学习目前仍处于起步阶段,而且它的自动化比普通神经网络也困难许多。

大部分AI都是通过分析大量数据寻找其中隐藏的规律。全球IT服务公司L&T Infotech的执行副总裁兼首席数据分析官苏门德拉·莫汉蒂(Soumendra Mohanty)表示,“显然,这能使我们能了解到‘是什么’,但却很少能理解‘为什么’”。

这个区别的影响是很大的。建造人工智能的最终目的是训练AI回答为什么这个因素会影响那个因素,这就是许多研究人员现在将注意力转向这儿的原因。

加州大学洛杉矶分校的教授朱迪亚·珀尔(Judea Pearl)的关于实施贝叶斯网络统计分析的研究取得重要成绩,他在开发一个可以在可计算框架中区分事件原因的、用于绘制因果关系图的框架。

分析因果关系的最大挑战之一是通过专家判断一件事情的原因,此为主观意见,然后再通过各种分析技术将其分开。这与统计机器学习所追求的“客观”形成鲜明对比。长远来看,因果关系研究可以帮助我们更好地理解世界;短期内,因果分析也可以更好地解释机器学习模型的结果。

不再期待AI奇迹般地预测未来

Information Builders营销副总裁杰克·弗赖瓦尔德(Jake Freivald)说:“商业精英通常不相信黑盒子技术,但他们却对人工智能技术有着异乎寻常的期待。”他表示,企业家意识到将业务流程交给人工智能算法可能就像让他们两岁的孩子驾驶自己的汽车一样冒险。

问题在于,分析型AI主要用于查找数据集中的相关性,而相关性仅仅能暗示因果关系,无法准确解释事情为什么发生。相关性只能告诉你接下来可能会发生什么。

“我们越能在模型中梳理出因果关系,就越能在现实基础上准确评估事情发生的原因以及接下来会发生什么,”弗雷瓦德说,“只有到那时,将业务交给人工智能就可以很好地完成工作。否则,结果可能是灾难性的。”

不再仅仅是拟合曲线

拟合曲线在回答诸如“下一个最佳报价是什么?”、“这会是诈骗吗?” 或者“它是猫吗?”这类问题上表现出色。

“但现实世界中,很多问题是无法仅通过曲线拟合度解决的,”莫汉蒂说。如果几个因素都可以预测产品偏好,那企业应该选择哪些因素以及如何确定其重要性顺序呢?简单地将不同变量按强度排列与独立选择一些因素并单独评估其对预测结果的贡献程度的结果是不同的。

“我们可以观察相关性,但并不能证明甚至解释因果关系,”莫汉蒂说。因果关系回答的是“我应该采取什么行动才能实现改变?”或“如果我改变模型的一些基本假设会怎样?”

因果深度学习技术(又称结构方程模型SEM)已存在多年了。然而,这些技术或多或少地局限于学术研究,目前还没有应用到商业领域。

蒙特卡罗模拟,马尔可夫链分析,朴素贝叶斯和随机建模是当今常用的一些技术,但它们几乎都不能分析因果关系。还有一些开源软件包,如DAGitty(一个基于浏览器的环境,用于创建,编辑和分析因果模型以及Microsoft的DoWhy库的软件包)也用于因果推理。但这些仍在发展中。

自动库存管理系统的制造商Pinsa Systems的首席执行官兼总裁理查德·施瓦茨(Richard Schwartz)表示,在整体上看,AI应用程序会根据其观察到的模式执行一系列操作。深度学习使用统计技术来发现规律。在AI中嵌入因果理解的不同方法需要开发基于规则的系统。这种系统可以从其他类型的客观事实中得出结论,例如“右转三次等同于左转”。

规则可以是因果关系或认知关系,它们有助于根据输入对结果进行建模,但它们也有缺点:“因果规则很难界定的,明确定义往往更难。”

潜在的解决方案是两种方法的组合,例如,为神经网络创建可解释性模块。这种系统的因果深度学习模式是以更加艰苦的方式构建如何达成结论的认知模型。

另外一种比较好的因果AI技术是通过强化学习领域的“从示范中学习”(Learning from demonstration),这种方法首先输入一些计算机完成某些事情的例子,然后让计算机适应该技术,自己解决问题。

彭萨(Pensa)在其库存管理工具中使用两种类型的人工智能来解决与商店货架上重新进货库存相关的问题。主要产品使用神经网络,用以解决摄像机的计算机视觉输入识别货架上的物品(例如,亨氏牌番茄酱)以及货架的摆放方式(例如,亨氏牌产品通常在亨特牌产品的旁边)等问题。

使用因果模型生成自动提示,例如“亨氏番茄酱快要缺货”,或者“亨氏番茄酱已经完全缺货”。为了得出这个结论,系统不仅需要识别产品,还需要理解货架上物品的相关库存控制规则以及重新进货的意义。

人类通常非常擅长得到认知型结论,例如制定经验法则,从而得出结论。“这是人工智能的瓶颈,”施瓦茨说。

无需模型的因果关系

德克萨斯大学奥斯汀分校的人工智能教授斯科特·尼克姆(Scott Niekum)说,强化学习本质上是因果关系,因为智能体会尝试不同的方式并通过反复试验来了解其是如何得到结果的。这种类型的学习被称为“非模型学习”,很受欢迎,因为它可以学习正确的或有效的行为而无需学习世界是如何运作的。

换句话说,智能体学习行动与后果之间的因果关系,而不是行动如何直接影响世界的。例如,它可以在不了解水和火之间的关系的情况下翻转火上方的水桶将水倒出用来灭火。

非模型学习是一把双刃剑。如果没有模型,智能体就必须从头学习如何在问题发生变化时解决问题。

在前面的例子中,如果给智能体一个水管而不是一桶水,它就不知道怎么办了而需要从头开始学习,因为它只学习了“翻桶”行动与扑灭火灾,并没有学习水和火之间的因果关系。

尼克姆说:“由于这些原因,人们越来越关注基于模型的强化学习,尽管它也有缺点,例如,如何衡量模型的置信度,模型错误时该怎么做,如何管理大范围长线计划的不确定性?”

解释机器学习模型

可解释性的核心是这样的:解释必须能够识别和量化所有对深度学习模型的行为负有因果关系的因素。在这方面,因果关系是指模型函数本身,而不是模型正在解决的任务,Fiddler Labs(一家可解释的AI引擎公司)的数据科学负责人安库尔·泰利(Ankur Taly)表示。

由于模型的复杂性,完整地解释深度学习模型很难。难以分析推断模型函数中每个特征的重要性,早期的因果深度学习方法是通过观察模型对数据集的预测,在其中拟合一个更简单、可解释的模型来解释它。

“不幸的是,这些方法容易受到从观察数据推断因果关系的影响,”泰利说,人们无法将与模型预测真正相关的特征与那些与之相关的特征区分开来。

最近出现了一套基于合作博弈理论的Shapley值的不同算法。这些算法使用反事实输入探测模型。然而,FiddlerLabs的研究发现,如果数据集不是正态分布的,这些算法大多数情况下都会导致偏差。泰利说他们正在研究将解释模型与特定数据集分离的方法。

这种研究有助于识别模型学会依赖的虚假相关性。例如,黑客最近可以通过添加某些类型的数据来伪造Cylance反恶意软件引擎。减轻这种风险的第一步是确定显著影响模型预测的因果特征。

“然后人们可以通过研究这些特征来检查它们是否也是这项任务的原因,或者它们是否被对手利用了,就像Cylance一样,”泰利说。

不可盲目迷信AI

据Information Builders的弗赖瓦尔德说,目前人类可以比AI更好地通过深度学习建立因果关系。这涉及到限制数据集,剔除可能导致偏差的字段,并塑造学习过程。人类关注因果关系,让算法完成学习过程。这是一个反馈循环,但人是必不可少的。

如果因果关系可以由人工智能决定,那么人工智能可以重塑学习过程而不再需要人类。理论上,AI可以使用任意数据集来确定因果关系,并以人类完全没意料到的方式进行学习。

目前还是存在很多未知的。人类可以用自己广泛的智慧解决问题,而机器尚无法做到。最近的尝试还产生了不少令人头疼的并发症。“我们希望人工智能越万能,需要的数据就越多,误报的可能性也就越大——这是机器的局限,我们不能盲目的迷信机器,”弗赖瓦尔德说。

时间:2019-08-27 15:30 来源:可思数据 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: